Ethique de la programmation : un dispositif expérimental mené dans un IUT d’informatique

Les Institut Universitaires Technologiques offrent aux étudiants une formation à visée professionnelle avec un enseignement fortement technique. Cependant, l’exercice de la profession d’informaticiens les positionne en tant qu’acteurs centraux de numérisation de la société. Leur vigilance éthique n’étant que rarement interpellée, sont-ils à même d’interroger leur responsabilité lors du développement d’applications informatiques à forte performativité sociale ? La pensée, le doute, la critique sont des principes adaptatifs d’interrogation sur le bien et le mal. Un dispositif pédagogique pluridisciplinaire a été construit à l’IUT autour de la question controversée des Deep Packet Inspection1 (DPI) selon une approche didactique issue du champ des Questions Socialement Vives. L’objectif vise à amener les étudiants à un questionnement éthique construit autour de la responsabilité de leur développement de logiciels. Dans cet article nous analysons les cartes heuristiques construites par les étudiants au cours du travail d’enquête réalisé pendant la formation. Nous montrons que ce dispositif est pertinent pour amener les étudiants à penser la responsabilité de l’informaticien, impliqué dans le développement de DPI.

Institut Universitaires Technologiques provide a vocational training grounded on technological skills. Although IT professional are at the heart of society digitalization, their ethical alertness is hardly ever reminded. The question is : are they able to reflect on their own responsibility when they develop high social performativity computer application ? Because thought, doubt and criticism are adaptive principle of good and bad questioning, we build an interdisciplinary experimental design based on the Deep Packet Inspection2 (DPI) Socially Acute Questions (SAQ). The aim is to bring students to an ethical awareness on software development responsibility. In this paper student’s mind maps builded during this teaching session are analyzed. We relate that this design experiment is relevant to bring student thinking about IT responsibility involved in DPI development.

Introduction

La numérisation de la société est aujourd’hui au cœur de l’actualité médiatique : selon certains observateurs, le résultat de la dernière élection américaine serait en partie due au phénomène tunnels cognitifs (Bronner, 2016) crées par les réseaux sociaux qui renforcent les opinions de chacun et limitent l’accès aux démentis d’informations erronées comme par exemple le financement de Daesh par Barack Obama. Face à ces critiques, Mark Zuckerberg le fondateur et président de Facebook (le principal réseau social avec plus d’un milliard d’abonnés actifs dans le monde) répond sur deux points : premièrement, les algorithmes sont neutres (leur unique objectif est de sélectionner les informations susceptibles d’intéresser les internautes) et deuxièmement, Facebook est une technologie et non un média comme les journaux ou la télévision qui eux, ont à répondre devant la justice de la diffusion d’informations erronées.

Or l’enseignement de l’informatique est pensé comme tel : une science ou une technologie à transmettre aux étudiants. Dans les formations professionnalisantes des Instituts Universitaires de Technologie, l’influence potentielle de cette technologie dans la société est abordée à la marge dans le cadre d’un projet tuteuré en 1ère année (PPN, 2013). Les enjeux éthiques liés à la profession ne sont jamais mentionnés : l’informaticien qui implémente un algorithme (comme celui très critiqués de Facebook par exemple), est considéré comme ne prenant aucune une part de responsabilité dans l’usage qui est fait du programme. Qu’en est-il réellement ? Que dire des actes d’Edward Snowden (Snowden, 2016), qui après avoir travaillé en tant qu’informaticien à la NSA s’est transformé en lanceur d’alerte, estimant avoir outrepassé ses valeurs personnelles en pratiquant un métier qu’il avait choisi et qu’il aimait ? Que dire de James Dunne (Dunne, 2015) qui a découvert subitement dans la presse, que le logiciel sur lequel il travaillait avait été vendu à Kadhafi qui s’en servait pour repérer ses opposants politiques et les torturer ?

Ces différents cas et les questions sociétales soulevées nous permettent de penser que dans le cadre de notre formation, il est important de pouvoir sensibiliser les étudiants aux enjeux éthiques de leur future profession : un algorithme est-il réellement un objet technique neutre ? Quelle est son influence potentielle sur le monde ? Quelle est ma part de responsabilité dans le développement d’applications ?

C’est reprenant les travaux d’Annah Arendt sur la banalité du mal (Arendt, 1991) et en s’interrogeant sur la modernité réflexive (Beck, 2003), que nous avons imaginé un dispositif pédagogique innovant pluri et interdisciplinaire construit autour d’une approche didactique issue du champ des Questions Socialement Vives (Legardez & Simonneaux, 2006) permettant d’aborder la programmation non pas comme un savoir froid et disciplinaire, mais comme un savoir polysémique intrinsèquement lié aux enjeux de la société.

La question de recherche que nous abordons ici est de déterminer si ce type de dispositif est à même de pouvoir sensibiliser les étudiants à un questionnement éthique lié à la profession d’informaticien. Après avoir présenté le contexte du dispositif et les soubassements théoriques, nous détaillons l’étape portant sur l’étude d’Edward Snowden et c’est à travers l’analyse des cartes heuristiques produites par les étudiants que nous interrogeons la question de l’éthique et des programmeurs.

Contexte du dispositif

Le dispositif interdisciplinaire a été mis en place en 2013-2014 à l’IUT A Paul Sabatier de Toulouse (Université Toulouse III). Il rentre dans le cadre d’un projet « Bonus Qualité Formation » (BQF) : il s’agit d’encourager les initiatives innovantes d’équipes pédagogiques. Les projets retenus bénéficient d’un soutien financier (en heures) et technique (si besoin) pendant 3 ans.

Ce dispositif est construit collaborativement par des enseignants de disciplines différentes : informatique, mathématiques, économie, droit, anglais, expression-communication. Comme aucun créneau n’est officiellement alloué à cet enseignement, le dispositif s’intègre dans ceux existants. Le Tableau 1 présente un synopsis des séances qui comprennent une partie de cours magistral où sont présentés le concept d’éthique en philosophie, de cryptographie et de DPI (Deep Packet Inspection), une partie étude de cas où nous étudions les agissements d’Edward Snowden et une partie mise en situation où nous leur proposons un travail et un stage posant des problèmes éthiques face auxquels ils doivent se positionner. Les méthodes pédagogiques employées dans ce dispositif sont issues des méthodes agiles (Viallet & Panissal, 2016).

|

Objectif |

Modalité |

Durée |

|

1-CONCEPTS Présentation du dispositif et de concepts incontournables dont l’éthique et la cryptographie |

Cours magistraux à plusieurs voix (180 étudiants) |

3* 1,5 h |

|

2- ETUDE DE CAS : Edward Snowden

|

Visionnage du film en amphi et en TP d’anglais (vocabulaire) Travail individuel TP de droit co-animé par les enseignantes de droit et d’informatique (12 groupes de 15 étudiants) |

3*1,5h |

|

3- MISES EN SITUATION Vous avez été repéré comme étant un étudiant très brillant en informatique : quelles sont vos conditions pour accepter un travail dans le DPI ? Accepteriez-vous un stage dans une grande entreprise où il s’agit de faire des statistiques sur des personnes travaillant sur une hotline téléphonique ? |

TP de droit co-animé par les enseignantes de droit et d’informatique (12 groupes de 15 étudiants) |

1,5 h |

Tableau 1 : les différentes étapes du dispositif

Emergence d’une Question Socialement Vive : le cas Edward Snowden

- Note de bas de page 3 :

-

Selon lui ils ne respectent ni les 4éme et 5éme amendements de la constitution, ni certains traités des Nations Unis souscrits par les Etats-Unis

Edward Snowden est un informaticien qui a été embauché par un sous-traitant de la NSA en 2009. De par ses fonctions, il avait accès à des informations qualifiées de « secret défense ». Un jour il a contacté un journaliste, Glenn Greenwald pour pouvoir divulguer au monde que l’état américain espionne les internautes du monde entier en employant une technologie très en pointe et remarquablement efficace. Il agit ainsi car il estime ces agissements condamnables3 et espère les faire cesser. Durant la période où il effectue ses déclarations, la cinéaste Laura Poitras le suit également et filme une partie de ses révélations, ce qui a donné lieu à un long métrage paru en 2015 dont le titre est « Citizen Four », le pseudonyme employé par Edward Snowden lors de ses premières révélations.

La question de la légitimité des actes de Citizen Four est abondamment traitée dans la presse tant francophone qu’anglophone : Edward Snowden est-il le héros qui a dénoncé l’état américain qui ne respecte pas la vie privée de ses citoyens ou bien un traitre qui divulgue des informations classées défense et met en péril la sécurité de son pays ? Quelles sont les motivations réelles qui l’ont poussé à renoncer à toute une vie pour divulguer ces informations ? Sa décision est-elle éthique ? L’informatique se doit-elle d’être transparente vis à vis de tous ses utilisateurs ou bien peut-elle être considérée comme une arme secrète ?

De la technologie vers la question éthique dans l’enseignement

- Note de bas de page 4 :

-

http://www.lemonde.fr/proche-orient/article/2012/09/03/accuse-de-commercer-avec-damas-qosmos-porte-plainte-pour-denonciation-calomnieuse_1755081_3218.html consulté le 24/11/2016

Au second semestre de la première année de DUT Informatique, lors du premier TD sur les réseaux, un enseignant demande aux étudiants d’interpréter quatre entêtes de messages codés selon différents protocoles(Ethernet, ARP, IPv4, ICMP, TCP et UDP). Ces messages sont extraits, via un logiciel spécifique, de communications existantes. Les étudiants constatent qu’ils ont accès à un ensemble d’informations liées à la vie privée de l’utilisateur comme le serveur utilisé, le nom du navigateur de l’utilisateur ou les caractéristiques de l’ordinateur. La technologie évoquée dans cet exercice est le Deep Packet Inspection (DPI) ou Inspection de Paquets en Profondeur qui, associée à des moteurs de reconnaissance, permet l’analyse du trafic Internet via l’interception et l’interprétation de communications numériques. Ces logiciels peuvent être commercialisés à des gouvernements, entreprises ou particuliers. On a pu lire en 2012 par exemple dans la presse que la société Qosmos, une startup française, est accusée par la Ligue des Droits de l’Homme et la Fédération Internationale des Droits de l’Homme d’avoir fourni des moyens d'espionnage à des entreprises en contrats avec les dictatures de la Syrie et la Libye, ce qu’elle dément4. Les fonctionnalités de ce type de logiciel correspondent à celles que la NSA emploie, leur étude technique peut-être ouverte

La question soulevée est celle de la place que certains logiciels occupent dans la société. Selon les fédérations des droits de l’homme, les logiciels commercialisés par Qosmos sont des armes de guerre ; selon les services secrets français (la DCRI qui est cliente de Qosmos), des moyens efficaces de lutter contre la « pédopornographie » ou la propagande terroriste par exemple.

L’inscription du DPI dans la didactique des Questions Socialement Vives

Dans cet article nous étudions le savoir controversé DPI selon une approche didactique dans le champ des (QSV) Questions Socialement Vives (Legardez & Simonneaux, 2006). Il s’agit d’un savoir vif, complexe tant au niveau des savoirs de référence. Il n’y a pas, en effet, d’uniformité de définition étant donné que le DPI est en lui-même une simple appellation (une étiquette) renvoyant à tout un ensemble de technologies logicielles et matérielles de différentes natures. Son usage est controversé dans la société, comme nous l’avons précédemment vu. Compte tenu des deux vivacités précédentes, il est aisé de comprendre que cette QSV du DPI est particulièrement délicate à enseigner.

Comme les technosciences ont un impact performatif sur nos conditions de vie (Callon, Lascoume & Barthe, 2001) en les transformant en profondeur, la question de la responsabilité de l’homme face au développement technologique en amont et ses usages en aval est d’une importance cruciale. Le citoyen doit être en mesure de mobiliser une rationalité critique c’est-à-dire une rationalité scientifique caractérisée par l’objectivité scientifique, nouée à une rationalité réflexive fondée sur la critique, la vie quotidienne, les considérations éthiques (Beck, 2003 ; Simonneaux & Simonneaux, 2014). Le progrès et la notion d’incertitude sont désormais problématisés dans nos sociétés. La prise en charge des risques et des incertitudes ne peut se faire qu’au niveau global, international. Il convient de penser le monde comme multiple et cosmopolite (Beck et Grande, 2010) où tous les pays doivent coopérer pour prendre soin des humains. La frontière entre science et politique se retrouve gommée.

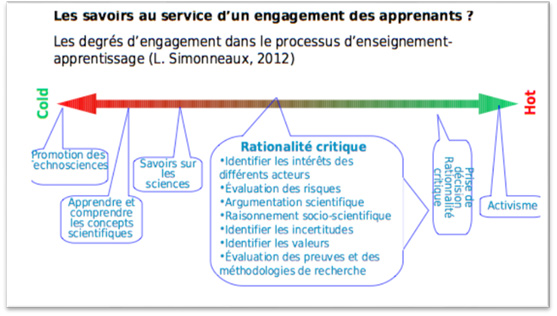

La question du comment enseigner ces savoirs incertains, entachés de valeurs est alors vivement posée. Convient-il de perpétuer un enseignement qualifié de traditionnel et caractérisé par un clivage disciplinaire fort. Les pratiques éducatives seraient alors tentées de « refroidir » le savoir et d’effectuer une promotion des technosciences comme l’illustre la Figure 1. Une autre approche consiste à faire entrer l’enseignement scientifique dans une pédagogie de questionnement du monde (Ladage & Chevallard, 2010), sur les interactions des sciences et de la société, dans la culture citoyenne, voire même jusqu’à engager des actions militantes (Figure 1). Ainsi l’apprentissage peut devenir l’enjeu d’un engagement dit militant des élèves, interroger la question de la justice sociale, du changement de modèle de société et questionner la responsabilité individuelle (Bencze, Sperling & Carter, 2012).

Figure 1 : Modèle de Simonneaux & Simonneaux sur les degrés d’engagement

La mobilisation de la pensée critique est au cœur de cette didactique engagée (Simonneaux & Simonneaux, 2014). Plus précisément nos travaux s’intéressent au développement à la pensée éthique des étudiants programmeurs informaticiens, comme sous ensemble d’une pensée d’excellence (Lipman, 2003). Selon l’auteur, la pensée d’excellence est composée de trois éléments : une pense critique, une pensée créative et une pensée éthique. La pensée éthique correspond à la faculté à porter des jugements sur les critères qui permettent d’évaluer la question du bien commun et de l’important (Sharp, 2004). Nous empruntons la définition de Gagnon (2008) qui conçoit la pensée éthique comme une praxis mobilisant écoute, respect d’autrui afin de mesurer les conséquences éthiques avant de prendre une décision responsable. L’objectif de l’ingénierie d’éducation présentée ici consiste à amener les étudiants en IUT d’informatique à s’interroger sur l’activité professionnelle de programmation, non pas simplement comme un disciplinaire (savoir froid), mais comme un savoir polysémique intrinsèquement lié aux enjeux de la société et aux enjeux éthiques. Il s’agit d’interroger les activités de programmation comme des outils potentiels de pouvoir et d’amener les concepteurs (ici futurs concepteurs) à réfléchir à la question de leur responsabilité dans la numérisation de la société.

Cadre théorique multiple du dispositif interdisciplinaire

C’est en observant Adolf Eichman en 1961 au procès de Jérusalem, que Hannah Arendt fonde le concept de banalité du mal (Arendt, 1991). Selon elle, tout un chacun peut potentiellement devenir criminel. Les criminels nazis sont pleinement responsables de la shoah, même s’ils faisaient partie d’un système qui les dépassait : ils ont en effet consenti. Si tous avaient refusés de faire le travail demandé (comme par exemple mettre un nombre donné de personnes par wagon), il n’y aurait pas eu de nazisme ; les préoccupations de chacun se sont montrées plus fortes que ce refus.

Néanmoins dans le cadre d’une éducation à la responsabilité d’étudiants futurs informaticien, il convient de distinguer en amont la différence entre la responsabilité juridique (légalité) et la responsabilité morale (moralité) car toutes les actions légales ne sont pas nécessairement morales. En l’occurrence, les actions de la NSA sont légales mais non morales. La responsabilité morale consiste à répondre de sa liberté. C’est à dire qu’un individu est à même de prendre une décision en son âme et conscience indépendamment de toute autorité, qu’il reconnaît le bien du mal et la liberté. En contrepartie, il devra justifier ses actes, ou de celle des autres, acceptera d’être jugé en rapport et en assumera les conséquences. Pour assumer une telle responsabilité (morale), l’individu doit être libre dans sa décision. Il doit pouvoir mobiliser sa pensée, comparer, choisir tel ou tel acte en connaissance de cause. C’est en ce sens que la responsabilité morale est intrinsèquement liée à la liberté d’action. Néanmoins, il ne faut pas rabattre cette responsabilité à ses conséquences juridiques mais l’ouvrir sur la question plus large de qui est responsable, dans un enchaînement en cascade de responsabilités. Quels sont les partages de responsabilités à envisager dans un contexte professionnel ou par exemple l’informaticien programme, le commercial vend le produit et le chef d’entreprise signe les contrats ? Il s’agit bien de s’interroger sur la proportionnalité de sa responsabilité. La responsabilité ainsi pensée devient alors une praxis, un processus visant à penser, voire à prévenir et anticiper les conséquences de ces actions. C’est ainsi que ne rien faire, se conformer, obéir peut déclencher une responsabilité. Il s’agit ainsi d’un principe de responsabilité au sens Jonassien (1979) qui conçoit la responsabilité comme un impératif de ne pas mettre en péril la survie de l’humanité et l’intégrité de l’homme, y compris pour les générations futures ; une éthique de la responsabilité à visée téléologique qui consiste à répondre (au-delà de soi et de ses actions), d’autrui, de sa vie sans attente de réciprocité (Lévinas, 1961) à répondre de sa vie présente mais aussi de l’autrui à naître. Ce type de questionnement, nous semble heuristique pour penserla question de la responsabilité de l’informaticien, engagé dans une entreprise de développement de DPI ou plus largement de programmes de numérisation de la société.

Cadre méthodologique

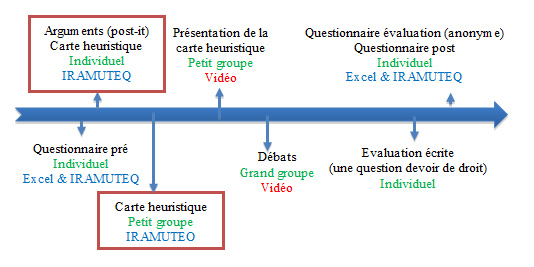

Le dispositif pédagogique présenté ici est exploratoire et suit les principes du design experiment (Cobb 2003) : il associe des enseignants et des chercheurs, en informatique, droit et économie, didactique (de l’informatique, des QSV). L’expérimentation vise à établir le cadre d’une éthique du programmeur ; les différentes expérimentations évoluent d’une année sur l’autre en fonction des besoins de la recherche et des disponibilités des enseignants partenaires ; il est encadré par un recueil important de données (questionnaires pré, post, d’évaluation du dispositif, vidéo des séances et notamment des débats, productions d’étudiants parmi lesquelles des cartes heuristiques) présenté Figure 2. L’analyse des questionnaires pré et post sur les 3 années interrogeant une évolution dans la pensée éthique des étudiants, a été présentée au congrès de l’AREF (Panissal & Viallet, 2016).

- Note de bas de page 5 :

-

Un script Shell a été écrit pour transformer la version HTML des cartes produites sous Freemind en un corpus textuel analysable par IRaMuTeQ.

- Note de bas de page 6 :

-

R est un logiciel libre de traitement des données et d'analyse statistiques mettant en œuvre le langage de programmation S (source Wikipedia consulté le 1/12/2016).

- Note de bas de page 7 :

-

La lemmatisation consiste à réduire sous forme « canonique » les mots d’un texte. IRaMuTeQ ramène ainsi tous les verbes à l’infinitif, les noms au singulier et les adjectifs au masculin singulier en utilisant des dictionnaires sans désambiguïsation.

Pour répondre à ces questions de recherche, nous analysons les cartes heuristiques produites (encadrées en rouge dans la Figure 2). Nous avons procédé par une retranscription de ces cartes5 que nous avons analysé via le logiciel IRaMuTeQ (Interface de R6 pour les analyses Multidimensionnelles de Textes et de Questionnaires). IRaMuTeQ propose un ensemble d’outils d’analyse textuelle dont le cœur est la méthode Reinert (Reinert 1987, Reinert 1990). La méthode Reinert utilise la classification hiérarchique descendante pour construire une analyse lexicale par contexte. Elle procède par le découpage du corpus préalablement lemmatisé7, en segments de textes correspondant à un nombre d’occurrences donné, afin de construire des classes de discours regroupant des segments de textes ayant des termes statistiquement proches (la distance mathématique utilisée est le Chi2). IRaMuTeQ propose également différents outils permettant l’interprétation de la sémantique des classes ainsi définies et de leurs liens. Il propose également d’autres outils d’analyse textuelle comme le nuage de mots.

Figure 2 : les différents recueils de données issus de l’éxpérimentation

Conditions de production des cartes heuristiques

Deux types de cartes heuristiques sont produits par les étudiants : des cartes individuelles et des cartes en petit groupe, dans deux contextes légèrement différents. La première année (2014-2015), les étudiants ont lu, en TD d’expression communication, une sélection d’articles portant sur l’affaire Snowden parus dans la presse. Ils en ont extrait une fiche argumentaire où ils devaient relever les arguments en faveur puis contre les agissements d’Edward Snowden, puis élaborer individuellement une carte heuristique à déposer sur Moodle.

- Note de bas de page 8 :

-

Citizenfour est le film documentaire réalisé par Laura Poitras, sorti en 2014, dans lequel Edward Snowden dévoile pour la première fois au monde entier, les agissements de la NSA (cf. émergence d’une question socialement vive).

En 2015-2016, nous avons remplacé l’étude de texte par le visionnage du film de Laura Poitras8 en amphi et en travaux dirigés. Les étudiants ont ensuite rédigé à partir d’un canevas assez détaillé fourni par les enseignantes d’expression-communication (cf. Annexe 1), une analyse filmique portant sur l’histoire, la narration, le montage et l’argumentation utilisée à l’égard d’Edward Snowden. Ils ont ensuite produit individuellement chez eux, une carte heuristique répondant à la consigne suivante : « Déposer ici la carte heuristique (format freemind) définissant les dimensions éthiques de la décision d'Edward Snowden de divulguer au monde entier les agissements de la NSA. Vous piocherez votre argumentation dans le film, les articles proposés à la lecture ainsi que vos propres recherches personnelles sur le sujet ».

Dans un second temps, dans le cadre d’une séance de travaux pratiques en petit groupe (15 étudiants maximum) encadrée par une enseignante de droit et une enseignante d’informatique, nous avons organisé un débat sur l’attitude d’Edward Snowden en utilisant des principes pédagogiques issus des méthodes agiles : chaque étudiant se doit de trouver deux arguments pour et deux arguments contre les agissements d’Edward Snowden et soumettre à la classe (via des post-it) ; les enseignants lisent alors chaque argument et créent des catégories qui très vite dépassent la dialectique initiale du pour/contre, pour ouvrir vers un ensemble plus larges de considérations, dont certaines sont du domaine de l’éthique. A l’issue de cet exercice, les étudiants se regroupent en petit groupes de 4 ou 5 et élaborent ensemble une nouvelle carte heuristique qu’ils déposent sur Moodle.

Conditions d’analyse des cartes heuristiques

Les cartes heuristiques produites par les étudiants sont censées être réalisées au moyen du logiciel libre freeMind puis déposées sur une plateforme d’enseignement, à savoir Moodle. Malheureusement, l’exercice ne donnant lieu à aucune évaluation directe, nous n’avons pas récolté autant de cartes que d’étudiants (à savoir 180 individuelles + 40 par groupe par année). De plus, environ un quart des étudiants ont déposé des cartes au format pdf, non directement exploitable. Enfin, certains se sont trompés d’emplacement de dépôt, mélangeant cartes individuelles et cartes collectives, alors que d’autres ont tout simplement déposé plusieurs fois la même carte, ne changeant que le nom de l’auteur. Tout cela sans compter les mises à jour de Moodle qui ont emportées avec elles, toutes les cartes de la première année (2013-2014) …

Au final nous avons récolté 39 cartes individuelles et 38 cartes collectives pour l’année 2015-2016 et 117 cartes individuelles et 39 cartes collectives pour l’année 2015-2016. Afin de ne pas fausser les résultats nous avons procédé à un tri afin que les cartes heuristiques identiques n’apparaissent qu’une seule fois. Nous avons pris 2 critères de comparaison : l’année et le mode individuel ou collectif de production.

Visées de l’analyse des cartes heuristiques

L’analyse de toutes les cartes heuristiques produites a pour objectif de valider notre hypothèse initiale : les agissements d’Edward Snowden qui selon nous relèvent de l’éthique de la responsabilité, est-il perçu ainsi par les étudiants ? Perçoivent-ils dans cette étude de cas, la différence entre la légalité et la moralité ? Sont-ils sensibles à l’engagement d’Edward Snowden dans sa cause ? Le « mal » que dénonce Edward Snowden, à savoir l’espionnage de toute la population américaine à son insu, le conçoivent-ils comme du domaine du banal ? Sont-ils sensibles à la prouesse technologique des logiciels de la NSA ? Réalisent-ils qu’ils sont à même de pouvoir exercer un jour le même métier qu’Edward Snowden ?

Les limites de l’analyse des cartes heuristiques

- Note de bas de page 9 :

-

Les nœuds reliés à la racine et tous leurs fils restent à proximité mais l’algorithme de lecture de l’arborescence par FreeMind (en profondeur d’abord) met côte à côte la dernière feuille d’une branche avec le nœud suivant relié à la racine.

Les cartes heuristiques permettent une synthèse des différentes dimensions de l’étude de cas. Elles sont construites autour de mots clefs qui sont explicités par d’autres mots-clefs ou des phrases. Or lors de leur retranscription en HTML, les liens hiérarchiques sont perdus9. Ainsi, l’analyse textuelle que nous avons élaborée avec IRaMuTeQ a-t-elle été conduite avec prudence en effectuant une comparaison systématique sur les cartes heuristiques citées.

Certains étudiants redoublants ont déposé jusqu’à 4 cartes heuristiques sur les 2 ans. Or même si celles-ci évoluent avec le temps, elles conservent souvent une part importante de l’ancienne version, mettant ainsi en exergue des termes ou des associations comme par exemple le terme doigt utilisé dans l’expression « il a mis le doigt sur une situation très critiquable » que nous retrouvons dans 3 cartes.

Méthodologie d’analyse

Pour analyser notre corpus nous avons débuté par l’élaboration d’un nuage de mots sur le corpus entier et sur différents sous-corpus (par mode d’élaboration et année) pour avoir une première vision globale de la terminologie employée. Ensuite nous avons appliqué la méthode Reinert sur notre corpus. L’interprétation a été réalisée selon les principes énoncés par Daniel Guy (Guy, 1990) en utilisant plusieurs outils proposés par IRaMuTeQ : le dendogramme et les AFC définissant les classes et leurs relations (ou oppositions), le profil, l’anti-profil, les profils de segments répétés et les segments de textes caractéristiques de chaque classe. Pour présenter les liens entre les classes nous nommons les facteurs issus de l’Analyse Factorielle des Correspondances (AFC). Pour présenter la sémantique de chaque classe de discours, nous lui attribuons un nom et la caractérisons par les termes et les segments significatifs, parfois également les termes de l’anti-profil. Les cartes heuristiques étant construites autour de noms et non de phrases, nous replaçons dans leurs contextes graphiques les segments issus d’IRaMuTeQ.

Analyse du corpus

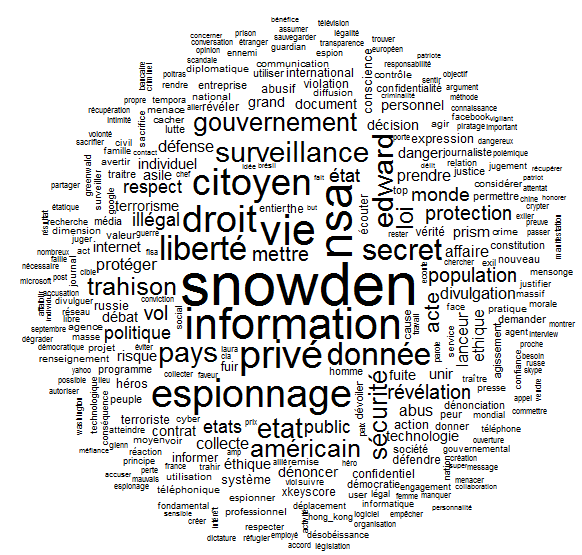

Notre analyse du corpus a débuté par la génération du nuage de mots construit sur leur fréquence (nombre d’occurrences) : plus le mot est fréquent, plus il est gros. Leur place sur le graphique ne traduit aucune relation entre eux. Les mots sont issu du corpus préalablement lemmatisé.

Le nuage de points issus de notre corpus (cf.Figure 3) montre que les termes choisis par les étudiants dans les différentes cartes heuristiques concernent bien l’affaire Snowden : Snowden, NSA, vie privée, données …. Il nous permet ainsi de vérifier que le corpus de données n’est pas hors du sujet qui nous intéresse. Les nuages de points construits sur les sous-corpus ne contenant que les cartes individuelles, les cartes par groupe, les cartes de 2015 ou celles de 2016 ne diffèrent pas de façon significative de celui du corpus complet. C’est pourquoi, notre analyse se poursuit (dans un premier temps du moins) sur le corpus complet. Afin de ne pas alourdir notre propos, nous ne faisons pas figurer les nuages de points des 4 sous-corpus.

Figure 3 : Nuage de mots du corpus complet

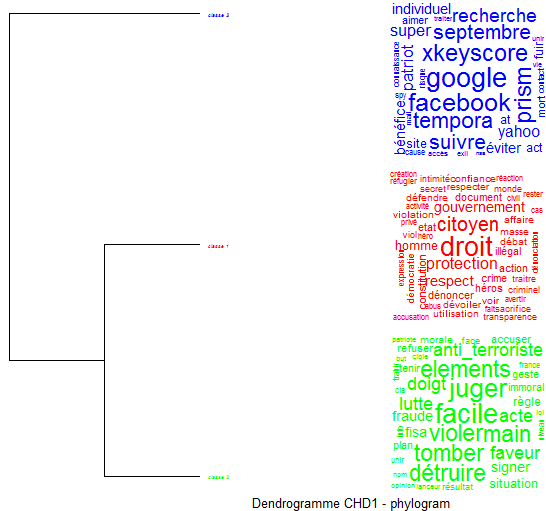

La seconde étape de l’analyse consiste à appliquer la méthode Reinert sur notre corpus et à identifier la sémantique des classes et de leurs liens. Cette analyse qui inclus 73,52 % des segments, produit pour débuter, le dendogramme présenté Figure 4 qui compte trois classes de discours, présentées via des nuages de mots établis en fonction du Chi2 de chaque mot dans la classe. La première classe qui regroupe à elle seule 72,2 % des segments est caractérisée par les termes : droits, citoyens, protection, sécurité, homme ; nous la nommons « droits de l’homme ». Nous dénommons « responsabilité » la seconde classe (8,7 % des segments) qui est construite autour des termes juger, violer, tomber, détruire. Nous nommons « informatique » la 3ème classe qui regroupe 19,1 % des segments classés et s’établie autour du nom des logiciels exploités ou construits par la NSA : Google, Facebook, xkeyscore, tempora.

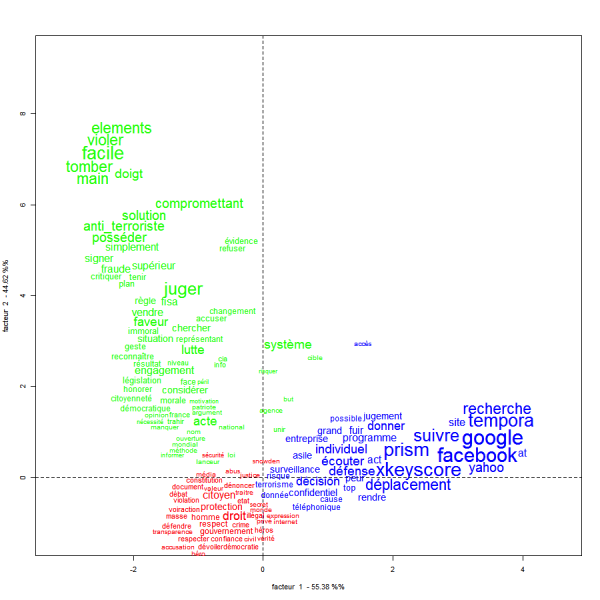

Nous avons ensuite étudié le résultat produit par l’Analyse Factorielle des Correspondances (AFC) : la Figure 5 présente l’AFC de notre corpus sur les termes ; leur grosseur est proportionnelle à leur Chi2 dans la classe. L’interprétation de cette analyse vise à essayer de déterminer sur quels axes se différencient les 3 classes afin de faire ressortir les facteurs caractéristiques de chacune pour dégager leurs particularités et d’organiser une vision globale des enjeux qui traverse le corpus.

Cette analyse permet de dégager deux facteurs discriminant des données : le facteur technologique et le facteur liberté. Les données de la classe informatique (classe 3) se distinguent sur l’axe horizontal (facteur 2) des deux autres : droits de l’homme (classe 1) et responsabilités (classe 2). L’ensemble des données de cette classe 3 se répartissent sur l’axe horizontal que nous nommons technologique dans la mesure où plus nous nous éloignons du centre, plus l’aspect technologique (nom de logiciels notamment) prend de l’importance.

- Note de bas de page 10 :

-

Source : dictionnaire lexicographique du Centre National de Ressources Textuelles et Lexicales (CNRTL)

Les deux premières classes se situent sur un axe vertical que nous nommons liberté : en bas la classe 1 traitant des droits de l’homme tels qu’évoqués par Edward Snowden dans son combat ; en haut, la classe 2 responsabilités qui concernent les conséquences des révélations d’Edward Snowden. Il est intéressant de noter l’opposition entre le citoyen (classe 1 droits de l’homme) dont la définition est membre d‘une communauté organisée10 - et la citoyenneté (classe 2 responsabilités) qui renvoie à la qualité de citoyen, dont le synonyme est nationalité. Dans la classe 1, le terme citoyen (Chi2 20,33) a pour segments représentatifs « collecte d’informations sur les citoyens du monde entier », « vie privée des citoyens ». Ce terme est associé à ce que dénonce Edward Snowden à savoir la défense des libertés individuelles, un des droits des citoyens. Le terme citoyenneté (Chi2 8,54) qui apparaît dans la classe 2 est quand à lui associé à deux branches « honorer son devoir de citoyen » et « il a mis le doigt sur une situation très critiquable ». Ce terme désigne ici l’attitude d’Edward Snowden qui l’a conduit à sa mise en accusation par l’état américain. Il ne s’agit plus des droits du citoyen mais de ses devoirs. Devoirs qui peuvent l’honorer ou le conduire à un jugement (cf. proximité avec le terme juger) et à une privation de citoyenneté (nationalité) donc de liberté.

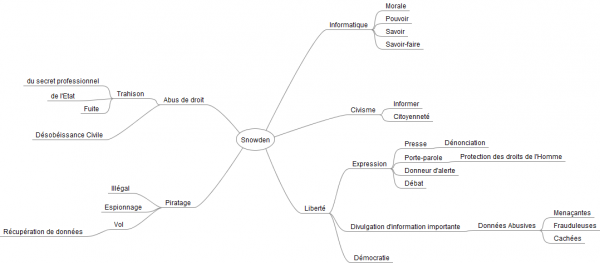

Figure 5 : Analyse Factorielle des Correspondances des 3 classes

Cette première analyse se doit d’être triangulée avec l’étude détaillée de chaque classe. Les termes significatifs de la première classe nommée droits de l’homme sont droit (Chi2 28,83), citoyen (Chi2 20,83), protection (Chi2 14,96), respect (Chi2 13,34) et gouvernement (Chi2 11,92). La carte heuristique présentée Figure 6 est la plus représentative de cette classe de discours : y sont expliqués à la fois les raisons qui ont poussé Edward Snowden à agir ainsi pour le « bien » de la société à savoir la préservation de libertés. A noter que les noms de logiciels comme Google (-43) ou Prism (-35,51) ainsi que le terme individuel (-24,15) appartiennent à l’anti profil de cette classe.

Figure 6 : carte heuristique représentative de la classe 1 (droits de l’homme)

La seconde classe représente une très faible part des segments classés. Les termes les plus significatifs sont juger (Chi2 51,49), violer (Chi2 42,52), tomber (Chi2 42,52), détruire (Chi2 42,52), antiterroriste (Chi2 32,48), compromettant (Chi2 32,48). Elle se caractérise par un discours qui porte sur la responsabilité qui incombe à Edward Snowden : le segment le plus répété est il a (Chi2 55,11). Il s’agit d’une série d’arguments plutôt en défaveur de ses actes : si les informations de Snowden tombent dans de mauvaises mains, n’a pas fait face aux conséquences de ses actes, Snowden n’a pas voulu être jugé.

La dernière classe informatique s’oppose aux deux précédentes sur l’axe technologique. Les termes les plus représentatifs sont des noms de logiciels comme Google (Chi2 70) ou Facebook (Chi2 65,49) qui ont une part active dans la surveillance des internautes ou xKeyScore (Chi2 58,56), prism (Chi2 70) et tempora (Chi2 55,14) qui sont les logiciels programmés par les services secrets américains et anglais. Il est question ici des révélations d’Edward Snowden, sans considération pour les citoyens (Chi2 -18,61) ou ses droits (Chi2 -10,46).

Une analyse complémentaire par sous-corpus ne s’est pas révélée pertinente car trop liée aux contingences de leurs productions : année ou groupe. Nous avons donc fait le choix d’arrêter notre analyse à ce stade.

Résultats

L’analyse des cartes heuristiques par IRaMuTeQ n’a classé que de 73 % des segments et construit une très importante classe de discours que nous avons nommée droits de l’homme. Nous pouvons en déduire que les cartes heuristiques présentent une grande homogénéité.

L’interprétation que nous avons faite de l’AFC montre que les deux dimensions de notre problématique, à savoir l’éthique d’un côté et l’informatique de l’autre sont bien traversées par le corpus des cartes heuristiques : dans l’affaire Snowden, ce qui est dénoncé - et peut être considéré comme « le mal » au sens de Hannah Arendt - provient de la privation des libertés due à l’espionnage de la NSA (classe 1 droits de l’homme) ; ce « mal » dénoncé par Edward Snowden le conduit à assumer les conséquences de ses actes : une privation de sa liberté personnelle (exil en Russie plutôt que d’assumer un procès), mise en danger de l’état (cf. terme anti-terrorisme dont le Chi2 est de 32,48 dans la classe 2 responsabilités). Parallèlement la dimension informatique n’est pas négligée puisque qu’elle est présente dans la classe 3 informatique sur l’axe technologique.

Ainsi nous constatons, au travers de notre interprétation de la sémantique des classes, que les étudiants ayant travaillé sur l’affaire Snowden ont identifié les éléments liés à leur discipline, l’informatique (classe 3) et ceux en relation avec les droits de l’homme. Ils ont également perçu (dans une moindre mesure) les risques liés au dévoilement d’informations classées secrètes pour les Etats-Unis et Edward Snowden lui-même (classe 2). Par contre nous ne trouvons rien de significatif concernant sa pratique professionnelle d’informaticien puisque rien n’est jamais évoqué concernant sa profession, son ancien employeur ou ses méthodes de travail. Les cartes situent l’action après ses révélations. De même, rien n’apparaît concernant la prouesse technologique développée par la NSA au travers de ses outils. Sans doute parce que les étudiants qui sont encore de très jeunes informaticiens ne l’ont pas perçu et que cet argument n’est que très peu évoqué dans le débat.

Nous pouvons donc affirmer, qu’au regard de ces cartes, il semblerait que l’étude du cas Snowden a permis de sensibiliser les étudiants à une certaine dimension de l’éthique de la responsabilité dans le domaine de l’informatique. Les notions de légalité et moralité sont présentes dans la classe 2 Responsabilité mais ne donne pas lieu à une distinction particulière. La classe 1 qui détaille abondamment les questionnements éthiques d’Edward Snowden concernant les écoutes de la NSA, montre que les étudiants ont été sensibilisés à son engagement, avec lesquels ils semblent d’ailleurs assez d’accord.

Si la notion de « banalité du mal » évoquée par Hannah Arendt peut sans doute être transposée aux arguments développés dans la classe 1 droits de l’homme, l’éthique de la responsabilité semble quant à elle limitée à la vision négative des agissements d’Edward Snowden. Une des raisons est sans doute que malgré ces révélations, très peu de choses semblent avoir changé dans le monde du numérique, que ce soit du côté des professionnels (qui espionnent toujours) que de celui des internautes (qui ne se protègent pas plus).

Discussion

Cette étude nous révèle que les étudiants sont sensibilisés aux conséquences que les révélations d’Edward Snowden ont eu tant sur sa vie privée que sur la société. Ce point est ici particulièrement intéressant car il montre que les étudiants sont parvenus à s’interroger sur la responsabilité morale d’un programmeur au-delà d’une déontologie professionnelle, contrairement à ce que nous avions pu observer antérieurement (Viallet & Panissal, 2016). Lors de travaux précédents, nous avions interrogé les mêmes étudiants au moment du lancement de l’ingénierie d’éducation, les étudiants étaient alors considérés comme novices par rapport à dispositif qui allait suivre. L’analyse des questionnaires que nous avions administrés montrait clairement que les étudiants s’interrogeaient peu sur les valeurs et restaient attaché aux pratiques professionnelles, ne considérant pas le côté personnel ou citoyen de l’informaticien. Ainsi, la question de la responsabilité morale n’était pas évoquée.

La phase de réflexion et d’enquête réalisée au service de la réalisation des cartes heuristiques montre clairement que ce questionnement moral fait désormais partie des considérations des étudiants et que le travail d’enquête exigé pour la réalisation des cartes heuristiques est un outil didactique au service du développement moral des intéressés. Au-delà de la situation présente, nous pouvons même envisager que cet outil puisse servir de levier didactique pour la suite de l’ingénierie. Il permet la co-construction d’un point d’ancrage sur lequel les enseignants peuvent s’appuyer pour travailler plus en profondeur la question de la responsabilité morale des informaticiens et les nécessaires aller retours à effectuer avec une déontologie professionnelle.

Conclusion

Dans cet article nous avons présenté un dispositif pédagogique expérimental mené par des enseignants et des chercheurs issus de différentes disciplines dans un IUT d’informatique, destiné à sensibiliser les étudiants futurs informaticiens à l’éthique de l’informatique. L’informatique, vue comme une science ou une technologie est enseignée comme telle. Pourtant la numérisation de la société pose des problèmes (Rouvroy, 2014). Les évolutions des technologies et de leurs usages font et feront nécessairement surgir des questionnements éthiques nouveaux, parfois en conflit avec les valeurs des informaticiens. L’éducation à la réflexion éthique doit ainsi amener les étudiants à penser et justifier les bonnes raisons d’agir, c’est-à-dire à développer une rationalité éthique guidée par des choix raisonnés (Simonneaux & Simonneaux, 2014) qu’ils doivent être amenés à pouvoir justifier en apportant des raisons plurielles, tenant compte des différentes parties prenantes (entreprise, sécurité, liberté individuelle, gouvernements, client, etc… ).

A la questions : les étudiants sont-ils sensibilisés à un questionnement éthique lié à la profession d’informaticien ? Nous pensons que le dispositif interdisciplinaire innovant mis en œuvre travaille la responsabilité morale de l’informaticien, c’est-à-dire l’obligation qui est faite à une personne de répondre de ses actes devant sa conscience, de justifier ses actes et d’en accepter la responsabilité. Ce type de raisonnement, nous semble heuristique pour penser la question de la responsabilité de l’informaticien, engagé dans une entreprise de développement de DPI ou plus largement de programmes de numérisation de la société. Ce pari s’inscrit comme une contribution à la formation à la pensée complexe qui permet de donner du sens à l’agir et à l’existence (Morin, 2005).