Camouflage et hiérarchisation des données : quelques exemples empruntés aux sciences de la nature

- Note de bas de page 1 :

-

Cet appareil permet entre autres, en pharmacologie, de mesurer les capacités pulmonaires des mammifères.

- Note de bas de page 2 :

-

Sur cette question, voir Allamel-Raffin 2004a.

- Note de bas de page 3 :

-

Du point de vue de la méthodologie, nous avons recouru aux techniques de recueil de données qui sont celles de l’ethnographie de laboratoire. Pour ce faire, nous avons séjourné plusieurs mois dans trois laboratoires différents. Nous avons effectué des observations participantes et réalisé des entretiens semi-directifs ayant pour objet central l’image scientifique. Les disciplines étudiées sont la physique des matériaux, l’astrophysique et la pharmacologie. Les études se sont poursuivies de 2000 à 2009. Cf. Allamel-Raffin, 2003, 2004a, 2004b, 2004c, 2005a, 2005b, 2009.

- Note de bas de page 4 :

-

Les laboratoires concernés sont en l’occurrence :

- en physique des matériaux, le laboratoire « Groupe Surfaces/Interfaces » (GSI) de Strasbourg, Le GSI est un laboratoire faisant partie de l'IPCMS (Institut de Physique et Chimie des Matériaux de Strasbourg, unité mixte CNRS-ULP. UMR 7504).

- en astrophysique, le Center for Astrophysics, Harvard University, USA.

- en pharmacologie, le laboratoire « Inflammation et environnement dans l’asthme » (IEA) intégré à la Faculté de Pharmacie de Strasbourg.

Les dispositifs techniques de visualisation, de dimension parfois impressionnante, que l’on trouve dans les laboratoires des sciences de la nature (des télescopes aux microscopes en passant par des instruments comme le plétismographe1) ont pour fonction de produire des images, que Bruno Latour et Steve Woolgar (1979), pour leur part, ont rangé dans un vaste ensemble baptisé « inscriptions ». Ces inscriptions remplissent dans le cadre du processus de recherche diverses fonctions et acquièrent différents statuts2. Pour aboutir à la réalisation de certaines de ces inscriptions, les chercheurs se livrent à des activités spécifiques qui consistent selon les cas à « camoufler » un « visible » jugé inintéressant ou parasite, ou à exhiber un « invisible » qui constitue pour une part essentielle la cible de l’investigation scientifique. Les pratiques expérimentales et instrumentales relevant du camouflage et de l’exhibition sont celles que l’on regroupe en général sous la catégorie « traitement des images » C’est à ces pratiques que le présent article sera consacré, l’intention étant par ailleurs d’exploiter le matériau empirique collecté au cours d’enquêtes ethnographiques3 menées dans des laboratoires d’astrophysique, de physique des matériaux et de pharmacologie4.

Cette visée va me conduire dans un premier temps à apporter quelques précisions sur les sens de deux termes antagonistes : « visible » et « invisible ». A quoi ces termes renvoient-ils précisément lorsque le cadre d’analyse a pour fonction de rendre compte de la production et des fonctions des images dans les sciences de la nature ? Je m’interrogerai ensuite sur les raisons pour lesquelles les scientifiques recourent aux dispositifs de visualisation. Quels sont les objectifs visés ? Dans un troisième temps, je tournerai mon attention vers la sémiotique visuelle élaborée par le Groupe µ et plus particulièrement vers la distinction opérée entre signe plastique et signe iconique. Ces concepts me permettront de mieux appréhender les différents traitements d’image qui ne sont en dernier ressort qu’une vaste entreprise de camouflage et d’exhibition, dépendant des objectifs multiples que les scientifiques assignent à leurs images.

1. Quelques précisions relatives aux termes « visible » et « invisible »

1.1. Des images scientifiques : rendre visible des inobservables

- Note de bas de page 5 :

-

Ce travail d’analyse a été mené, à la suite des positivistes logiques (et en particulier, de R. Carnap), par G. Maxwell (1962), H. Putnam (1962), B. van Fraassen (1980), I. Hacking (1981, 1983/1989), D. Shapere (1982, 1985), P. Kosso (1988a, 1988b, 1989), T. Pinch (1985a, 1985b). Par exemple, la question portant sur le point de savoir s’il y a entre les entités observables et les entités inobservables un continuum ou une dichotomie est fort intéressante, mais nous éloigne du propos central du présent article.

- Note de bas de page 6 :

-

Les images scientifiques retenues dans le cadre de cet article sont des images produites à l’ère de l’électronique. On peut voir là d'ailleurs la principale innovation du XXe siècle : l'abandon de la vision naturelle, au profit de l'extension du champ de l'optique à l'ensemble des rayonnements électromagnétiques. De surcroît, ces images donnent lieu à un traitement informatique.

Parmi les nombreux objets d’étude traités dans les trois laboratoires, GSI, CfA et IEA, on trouve par exemple : « le comportement des atomes de cuivre sur un substrat de silicium » ; « le mode de croissance de l’oxyde de nickel sur un substrat de cuivre » ; « la représentation de notre galaxie en ondes radio » ; « la distribution d’un petit nuage de poussières dans un nuage interstellaire » ; « la régulation par PPARα des inflammations des voies aériennes chez la souris », « l’expression accrue et diminuée de l’activité du cytochrome P450 1A1 dans le cadre d’un asthme induit chez la souris ». L’esprit le moins informé pourra identifier ici la présence d’entités inorganiques ou organiques et de processus physiques ou biologiques, inaccessibles au moyen du système perceptif visuel humain. Sans entrer dans une analyse détaillée du problème de l’observation et de l’observabilité dans les sciences de la nature5, je souhaite mettre brièvement l’accent, dans les lignes qui suivent, sur ce qui apparaîtra peut-être au lecteur comme un truisme : la nécessité, pour les chercheurs des trois laboratoires, de « rendre visibles » ces entités et ces processus inobservables. Cela présuppose, en règle générale, que l’on obtienne des représentations visuelles de ces entités et de ces processus, en d’autres termes que l’on soit capable de produire des images scientifiques6.

- Note de bas de page 7 :

-

Je propose ici une synthèse très simplifiée des travaux de D. Shapere (1982) et de P. Kosso (1988a, 1989).

- Note de bas de page 8 :

-

Ce terme est employé ici dans un sens très général.

- Note de bas de page 9 :

-

Dans cette perspective, l’œil humain peut être considéré comme un type particulier de récepteur électromagnétique, capable de détecter les ondes correspondant à une certaine gamme du spectre (D. Shapere, 1982, p. 506).

Pour mener à bien une telle entreprise, il faut disposer de récepteurs capables de saisir une information relative à une source (constituée par ces entités et ces processus physiques)7 en entrant en interaction avec elle. Un récepteur8 peut être défini comme un instrument capable de détecter la présence d’une interaction, et par conséquent les entités et les processus interagissant d’après les lois de la physique actuelle9. Par interaction, on peut entendre ici les quatre types fondamentaux, déterminés par la physique et connus à ce jour : électromagnétique, forte, faible et gravitationnelle. Une fois ces quelques précisions fournies, la question qui se pose concernant un objet d’étude donné est formulable ainsi : puis-je avec mes yeux voir l’entité ou le processus, ou dois-je disposer d’un instrument ? Dans le cas de l’utilisation d’instruments autres que l’œil en tant que récepteurs, et quel que soit leur degré de sophistication, la perception sensorielle humaine conserve un rôle important dans l’acquisition de l’information. Comme l’affirme Dudley Shapere, c’est nous, humains, qui avons monté les récepteurs appropriés, nous qui utilisons l’information obtenue comme information. Il faut donc que, quelle que soit l’information reçue par les récepteurs appropriés, elle puisse être conservée ou transformée, dans son état final, en une forme accessible aux sens humains.

Il faut d’autre part que cette information soit fiable, et cela suppose que l’on puisse déterminer son degré de fiabilité en suivant le trajet de l’information de la source jusqu’à son état final. C’est sur ce point que les difficultés apparaissent. Pour reprendre ce qu’en dit Trevor Pinch, à propos de la détection des neutrinos solaires (qui constituent également l’exemple central développé par Shapere dans son article de 1982) :

- Note de bas de page 10 :

-

Pinch (1985b, p. 91).

Les ‘points’ observés (…) n’en viennent à signifier la présence de neutrinos solaires que par rapport à d’autres étapes de la détection. Il semble que le processus d’observation se soit affiné jusqu’au point où ce qu’on pourrait appeler les ‘perceptions sensorielles primitives’ ou les résultats du ‘dispositif d’inscription’ ne forment plus que le dernier élément d’une chaîne d’inférences10.

- Note de bas de page 11 :

-

Je fais référence ici à deux dimensions seulement sur les quatre exposées par P. Kosso dans son ouvrage et j’emploie un vocabulaire qui m’est propre afin de les désigner.

Les inférences en question portent sur plusieurs aspects du trajet de l’information de la source au détecteur final. En simplifiant et en adaptant ce que Peter Kosso appelle les « dimensions de l’observabilité », on peut affirmer qu’il y a entre la source et le détecteur qui délivre l’information finale une certaine distance physique (« directness ») et une certaine distance nomologique (« amount to interpretation »)11. La mesure de la distance physique est définie par :

- Note de bas de page 12 :

-

Kosso (1988a, p. 456, traduction personnelle).

[ ...] la mesure du nombre d’interactions qui doivent se trouver tout le long de la chaîne d’interactions, de l’état initial à l’état final, de telle sorte que l’information est convoyée. Formulé simplement, quelle est la longueur que doit avoir la chaîne d’interactions depuis l’objet jusqu’à l’observateur ?12

L’information acquise avec une loupe est ainsi moins directe que celle obtenue à l’œil nu, et celle obtenue à l’aide d’un microscope l’est encore moins. La mesure de la distance nomologique se rapporte, quant à elle, au nombre de lois physiques impliquées par la corrélation entre l’état initial et l’état final de l’information, depuis la source jusqu’au détecteur final. Distance physique et distance nomologique entre source et détecteur final, c’est-à-dire entre les deux états, initial et final, de l’information, ne sont pas assimilables l’une à l’autre.

- Note de bas de page 13 :

-

Kosso (1988a, p. 456, traduction personnelle).

Ce qui est observable, moyennant de nombreuses interactions, n’est pas nécessairement dépendant d’un nombre équivalent de lois lorsqu’il s’agit de rendre compte de l’information ainsi rendue disponible. Prenez l’exemple de Shapere relatif à l’observation du centre du soleil à partir de photons. Cette observation possède un caractère éminemment indirect car il existe un très grand nombre d’interactions (..) requises pour que l’information soit transmise. Mais parce que ces interactions sont presque toutes de même nature, on peut rendre compte de cette transmission au moyen d’une seule loi de la physique, et une telle observation a une distance nomologique relativement réduite.13

- Note de bas de page 14 :

-

Artefact est pris ici au sens d’effet indésirable.

- Note de bas de page 15 :

-

Le processus de mise en visibilité est facilité par la présence de boîtes noires (voltmètres, ampèremètres, ordinateurs, etc.) qui contribuent à la production des images. Certaines de ces boîtes noires fournissent des informations aux scientifiques par le biais de cadrans chiffrés, ou d'aiguilles balayant une échelle de nombres, etc. Un certain nombre de ces boîtes noires remplissent cette fonction d’information au travers d'écrans où apparaissent des images, souvent des courbes. Pourquoi privilégier un mode de présentation plutôt qu’un autre ? Prenons un exemple en physique des matériaux : lors d’une observation réalisée avec un microscope à force atomique, pour contrôler le parcours de la pointe du microscope sur l'échantillon et afin de s'assurer qu'elle n'est ni trop éloignée, ni trop proche de la surface, un écran permet de visualiser le processus sous forme de courbes. D'un seul coup d'œil, le chercheur peut vérifier que le trajet effectué par la pointe est correct. Une telle image produite à l'écran ne sera jamais reproduite sur papier, mais constitue néanmoins une aide précieuse pour le chercheur. Ainsi, les images sont susceptibles de faciliter l’entreprise du chercheur, notamment au cours de la phase de réglage de son instrument, et contribuent à la qualité de son action en lui permettant de mieux la contrôler, la réguler et l’orienter. L’avantage des informations présentes sur l'écran sous forme d'images réside, en l’occurrence, dans leur caractère rapidement « parlant » et résulte de l'exploitation de la propriété que l’on reconnaît à l’image d’être plus synthétique que ne sauraient l’être des données chiffrées.

- Note de bas de page 16 :

-

Voir sur ce point Allamel-Raffin (2005b).

Ces deux notions de distance physique et de distance nomologique entre la source et le détecteur final permettent de préciser ce que l’on entend par des expressions telles que « la difficulté à saisir les inobservables ». Plus les deux distances sont grandes, et plus la question se pose pour les chercheurs de savoir si l'image qu’ils viennent de produire est le résultat d'un artefact14 dû à l'appareillage, ou si elle est conforme à leurs attentes et représente un aspect du réel15. Ainsi, lorsqu'un nouveau type d’instrument apparaît, l'une des premières tâches de ses inventeurs est de convaincre du fait que les images produites par son intermédiaire sont dignes de foi et ne se réduisent pas à un artefact occasionné par le prototype de l’instrument en question16.

1.2 La nécessité d’un regard informé pour exploiter cette mise en visibilité

De ce que nous venons d’affirmer sur l’activité de laboratoire consistant à rendre visible des processus ou des objets inobservables sous forme de représentations visuelles, découle la nécessité d’être doté d’un « regard informé » afin de déterminer le contenu sémantique d’une image. En effet, sur une image produite par les scientifiques destinée à rendre visible un phénomène donné, le profane ne distingue souvent rien d’autre que des formes et des couleurs auxquelles il ne parvient pas à assigner de signification.

- Note de bas de page 17 :

-

Visible en ligne sur http://chandra.harvard.edu/photo/1999/0064/0064_xray_lg.jpg.

Fig.1 Le quasar PKS 0637-752 en rayons X-17

Sur la figure 1, un regard non informé ne permet pas de tirer la moindre conclusion quant à ce qui est donné à voir : ici, le profane ne distinguera qu’une forme géométrique aux contours imprécis, dans une gamme allant du blanc au bleu, sur un fond noir. Comme le souligne Pascal Clément, « comprendre une image scientifique nécessite une connaissance préalable des codes scientifiques et iconiques qui lui donnent du sens, qui font émerger du signifié à partir de formes, qui sinon pourraient être interprétées à partir d’autres codes (familier, esthétique, psychanalytique). » (1996 ; p. 89).

Précisons quelque peu ce point : Fred Dretske (2000) distingue ainsi un voir non-épistémique (je vois une forme ovale et allongée sur la microphotographie) et un voir épistémique (je vois une mitochondrie sur la microphotographie). Il faut disposer des éléments d’information – et dans les sciences de la nature, des diverses théories convoquées dans le cadre de l’étude – pour que le phénomène soit visible en tant que tel sur l’image par l’observateur. Mais à l’intérieur de cette catégorie du voir épistémique qui correspond au regard informé du scientifique, il faut encore opérer une distinction : des scientifiques peuvent ne pas voir ce que d’autres scientifiques parviennent à identifier sur une image donnée. L’utilisation assidue de tel instrument, et la pratique régulière de l’observation des résultats obtenus sous forme de représentation visuelle au moyen de cet instrument, permettent à certains chercheurs d’acquérir un savoir souvent tacite qui rend visible sur l’image des éléments qui ne le sont pas pour d’autres.

Il faut donc ajouter ici une dimension qui correspond à ce que Lorraine Daston et Peter Galison ont appelé « trained judgment » dans leur ouvrage récent, Objectivity (Daston, Galison 2007), et qui correspond à ce que j’appellerai un regard entraîné.

Dans les sciences de la nature, peut donc être dit visible sur une image ce qui est donné à voir :

-

à l’œil nu ;

-

pour un regard informé ;

-

pour un regard entraîné.

- Note de bas de page 18 :

-

Voir Klinkenberg (dans ce volume).

Par voie de conséquence, on peut opérer la distinction suivante : est invisible tout ce qui ne satisfait pas le premier critère et non visible tout ce qui ne satisfait pas les deux critères suivants. Tout l’enjeu pour les scientifiques est de parvenir à mettre en œuvre des procédures fiables permettant de passer de phénomènes invisibles à des phénomènes visibles à l’œil nu pour un regard informé et entraîné. Pour reprendre l’expression de Jean-Marie Klinkenberg, l’enjeu consiste donc à rendre visible à tout prix18.

2. Pourquoi les scientifiques réalisent-ils des images ?

- Note de bas de page 19 :

-

Le point de vue génétique à propos des images scientifique consiste à se pencher sur le contexte de production correspondant à la question « comment les images sont-elles produites ?

A partir de ce qui précède, on a un début de réponse à la question : « pourquoi les scientifiques réalisent-ils des images ? ». Pour préciser ce point, je vais mettre surtout l’accent sur l’intérêt que présente l’adoption d’un point de vue téléologique, en articulant par ailleurs celui-ci avec un point de vue génétique (Allamel-Raffin 2009a, 2009b)19.

Je m’en tiendrai ici à l’essentiel. Le point de vue téléologique consiste à se poser des questions telles que : dans quel but l’image a-t-elle été produite ? Quelle est la meilleure forme de représentation pour atteindre un tel but ? Un tel questionnement a été développé par plusieurs philosophes des sciences anglophones ces dernières années : il résulte du constat que la relation de représentation, entendue en son sens le plus général, ne peut pas être caractérisée seulement sur la base de ce en quoi consiste l’artefact représentationnel, ni sur la base de ce qu’il représente. Il faut intégrer également dans l’analyse les possibilités en matière d’utilisation et de pratiques et les contextes dans lesquels elle s’insère, si on veut rendre compte de l’existence d’une représentation donnée (Van Fraassen, 2008, p. 31).

Le point de vue téléologique qu’il me semble nécessaire d’adopter, dès lors que l’on tente de développer une réflexion portant sur ces représentations visuelles que constituent les images scientifiques, s’inspire de la formule suivante de Ronald Giere (2006) : pour tous les éléments constitutifs des sciences empiriques (équations, modèles, données, et bien sûr les images) : « S [un scientifique] utilise X [une image, un modèle, une équation, etc.] pour représenter W [un processus, un objet] avec les finalités F ». Une image scientifique donnée doit donc être conçue comme profilée en vertu de telle ou telle finalité (souvent plusieurs à la fois, d’ordres divers), les finalités potentielles pertinentes étant multiples dans le cadre du travail scientifique.

A la formule de Giere, « S utilise X pour représenter W avec les finalités F » (2006, p. 60), j’ajouterai la précision suivante : des contraintes représentationnelles C pèsent sur l’activité de représentation de W. Ces contraintes représentationnelles sont principalement de deux ordres :

-

les contraintes liées à la détectabilité : ce sont les contraintes d’accès à l’objet d’étude W ;

-

les contraintes liées à la lisibilité : ce sont elles qui correspondent au point de vue téléologique : comment aboutir à la meilleure visualisation possible pour des modalités sensorielles et pour un entendement humains ? On met dans ce cas davantage (mais non exclusivement) l’accent sur les finalités F, qui déterminent la nature de X.

Tout autant que les contraintes liées à la détectabilité (correspondant au point de vue génétique), les contraintes liées à la lisibilité gouvernent en partie les choix en matière de réalisation d’images.

3. La distinction entre signe plastique et signe iconique (Groupe µ)

Les contraintes de lisibilité telles que je viens de les définir se laissent bien appréhender au moyen des concepts élaborés par le Groupe µ dans un autre cadre d’analyse. La distinction signe plastique / signe iconique, notamment, permet de mettre l’accent sur ces contraintes. Le concept de signe plastique oriente le regard de l’analyste vers les caractéristiques matérielles de l’image. On peut définir différentes familles de signes plastiques : les couleurs, les formes et les textures. Le signe iconique, quant à lui, qui va principalement retenir mon attention dans la suite, est « un type de représentation qui, moyennant un certain nombre de règles de transformations visuelles, permet de connaître certains objets du monde » (M. Joly, 1994 ; p. 96). Cette définition souligne que le signe iconique » possède des caractéristiques qui montrent qu’il n’est pas l’objet et affiche ainsi sa nature sémiotique » (Groupe µ cité par M. Joly, 1994 ; p. 97). « Le signe iconique possède certains caractères du référent, conformément à la définition classique (…). Il possède aussi certains caractères ne provenant pas du modèle, mais du producteur d’image » (Groupe µ, 1992 ; p. 133). C’est là que nous voyons à quel point ce concept se révèle pertinent aussi bien dans le domaine artistique que dans le domaine scientifique : le producteur de l’image introduit des caractéristiques qui ne proviennent pas du référent, mais des choix qu’il effectue lui-même en fonction des finalités qu’il s’est assignées dans le cadre d’une recherche donnée. Dans ce cadre-là, le Groupe µ propose une classification des transformations effectuées intention-nellement par le producteur d’images. Selon J.-M. Klinkenberg (2000 ; p. 387) s’inspirant de ses travaux avec le Groupe µ, la transformation est « un modèle rendant compte des ressemblances et des différences (de forme, de couleur, etc.) que l’on observe entre la représentation et l’objet de la représentation », et elle peut être de quatre types :

-

géométrique (projections, homothéties, transformations topologi-ques) ;

-

analytique (reposant sur l’algèbre : la discrétisation, par exemple) ;

-

optique (amélioration de contraste, rajout de couleurs) ;

-

cinétique (c’est l’observateur qui la produit en changeant sa position et donc l’angle de vision).

Nous verrons que ce sont bien ces types de transformation, parfois combinés, qui sont convoqués dans la phase de traitement des images sur laquelle je vais m’attarder dans les pages qui suivent. Le choix de recourir à l’un ou à l’autre de ces types de transformation est déterminé par la finalité que le scientifique assigne à l’image particulière qu’il cherche à produire.

4. Camouflage et exhibition

4.1. Types d’images retenues pour l’étude

- Note de bas de page 20 :

-

Cette catégorisation des images a été élaborée dans le cadre de mes enquêtes ethnographiques (cf. Allamel-Raffin 2004a, 2004b, 2004c). Elles ont été récemment amendées (cf. Allamel-Raffin C. 2009).

Pour cerner ce qu’il en est de la notion de traitement d’images, je limiterai mes remarques relatives à une typologie des images à deux catégories d’entre elles, produites au sein des sciences de la nature : les images sources et les images retraitées. Ce ne sont évidemment pas les seules catégories d’images existantes (on pourrait également parler des images de modélisation ou des images de simulation, par exemple). Mais ces deux catégories occupent une place essentielle dans la pratique expérimentale20.

4.1.1. L’image source

L’image source résulte d'une interaction entre trois éléments. En physique des matériaux et en pharmacologie, par exemple, ces éléments sont :

-

l’objet (l’échantillon) ;

-

la source de rayonnement (photons, électrons, etc.) ;

-

le dispositif « imageant ».

En astrophysique, l’image résulte de l’interaction entre :

-

les rayonnements électromagnétiques émis par un objet (source céleste) ;

-

le collecteur de ces ondes (les télescopes) ;

-

les processus imageants (désormais, il s’agit souvent de CCD, sauf en radioastronomie).

L’image source a donc la primauté d’un point de vue génétique : elle est la première dans l’ordre de production des images.

Fig. 2. Trois images sources (a), (b), (c) réalisées avec un microscope à effet tunnel d’un dépôt de rhodium sur un substrat d’or. Elles permettent de visualiser la topographie de l’échantillon (I. Chado/GSI).

4.1.2. L’image retraitée

L’image « retraitée » est constituée à partir de l’image source et peut revêtir diverses formes : courbes, images filtrées, etc.

Par exemple, en physique des matériaux, pour avoir une mesure beaucoup plus précise des variations de hauteur sur la surface de l’échantillon, le chercheur fixe deux points à l’intérieur de l’échantillon et trace une ligne virtuelle blanche (cela est fait sur la figure 2c). Il obtient le relief correspondant entre ces deux points : c’est la courbe (figure 2d) qui permet de visualiser le relief de l’échantillon le long de la ligne blanche. La courbe correspond ici à ce que nous appelons l’image retraitée.

- Note de bas de page 21 :

-

Ce paragraphe reprend les grandes lignes d’une réponse qui m’a été donnée par un astrophysicien (AD) lors d’un entretien, à une question portant sur les traitements d’images.

L’ensemble des opérations permettant de réaliser des images retraitées à partir des images sources ou des données sources correspond à ce qu’on appelle le « traitement » des images dans les sciences de la nature. Il est ainsi possible de sélectionner ou de combiner des paramètres relatifs à des propriétés physiques (température, vitesse de déplacement de la matière, variation des raies spectrales, etc., en astrophysique par exemple), d’obtenir des images de la deuxième ou de la troisième génération qui n’ont plus rien à voir avec l’observation directe. On peut ainsi réaliser des images de gradient de température, par exemple, de la manière dont la température varie d’un point à l’autre21.

L'image source de départ donne donc potentiellement lieu à diverses exploitations :

-

des graphiques (courbes, histogrammes, etc.) ;

-

d’autres images issues des images sources comme par exemple des images filtrées ;

-

d'autres images obtenues par simulation ;

-

d’autres images obtenues par modélisation ;

-

des schémas.

Ce travail mené à partir de l’image source repose sur des processus de mathématisation. A travers ces processus, il s’agit de rendre les différentes images commensurables, c’est-à-dire comparables, mais également de faire « parler » les images sources réalisées au moyen d’interactions entre un objet ou une propriété de cet objet, la source de rayonnement et le dispositif imageant – trop chargées d’informations. La mathématisation donne lieu à différents types de transformations, et notamment à des transformations analytiques, optiques et cinétiques au sens défini par le Groupe µ.

Je ne pourrai ici me livrer à un relevé exhaustif de tous ces types de transformations, mais je vais tenter de montrer que ces transformations des images visent aussi bien à camoufler le visible qu’à exhiber l’invisible.

4.2 Camoufler le visible

Les images sources sont celles qui comportent le maximum d'informations sur le plan quantitatif. Ces informations sont mises en cohérence sur le support, mais restent néanmoins difficilement exploitables, car elles sont souvent trop nombreuses. Dans les deux exemples que je vais présenter, il s’agit pour les scientifiques de retirer des informations visibles du support initial constitué par l’image source et de ne conserver que celles qu’ils jugent pertinentes pour leur étude, c’est-à-dire en regard des finalités poursuivies.

4.2.1 La correction du « champ plat » sur les images en astrophysique optique.

En astrophysique, les caméras CCD (pour l’anglais Charge Coupled Device) ont remplacé les films photographiques depuis les années 1980. Une caméra CCD comprend des lignes et des colonnes définissant les pixels de l’image finale. Chaque pixel de cette matrice est constitué d’un photo-détecteur assurant la conversion d’un signal lumineux en un signal électrique.

Le fonctionnement de ces détecteurs produit un certain nombre d’effets indésirables qui doivent être corrigés. En premier lieu, il convient de soustraire le bruit généré par l’instrument lui-même. Il s’agit principalement du bruit thermique produit par les détecteurs. Pour cela, on prend une image « à vide » – c’est-à-dire en l’absence de tout signal extérieur. Cette image, dite « signal d’obscurité » donne le « fond » qui devra être soustrait de toutes les images ultérieures : c’est ce que les astrophysiciens appellent une « image noire ». En second lieu, il faut tenir compte du fait que les nombreux photo-détecteurs qui constituent la caméra CCD ne sont pas parfaitement homogènes les uns par rapport aux autres. Deux photo-détecteurs ne répondront pas exactement de la même manière à un signal de même intensité. Un photo-détecteur donné peut même ne pas répondre du tout ; on parle alors de « pixel mort ». Cela risque d’induire en erreur les chercheurs lorsqu’ils produisent des images sources d’une zone céleste quelconque où des pixels de l’image sont peu ou pas fiables. Pour corriger cette absence d’uniformité, on prend par conséquent une image dite en « champ plat », en illuminant le détecteur de manière uniforme.

L’image est alors un « champ plat » réalisé en prenant une image d’un écran éclairé uniformément sous le dôme fermé du télescope. Ceci permet de repérer – et donc de corriger – les inhomogénéités induites par les photo-détecteurs.

Fig. 3. Image en champ plat réalisée avec un télescope optique, dôme fermé. K. Stanek. / CfA

Cette image sera soustraite de l’image source de la zone céleste considérée. Voici le résultat obtenu :

Fig. 4. Image d’une zone céleste corrigée à l’aide de l’image en champ plat. K. Stanek. / CfA

La finalité ici est de retirer certains effets indésirables visibles, l’objectif ultime étant de parvenir à obtenir une image ne comportant que des informations pertinentes. La transformation opérée est ici une transformation optique au sens du Groupe µ.

4.2.2. La suppression des étoiles non variables

Un astrophysicien a pour objet d’étude les étoiles variables (c’est-à-dire les étoiles qui émettent un rayonnement fluctuant dans le temps). Afin de mieux accéder à son objet d’étude, il peut décider de supprimer de ses images les étoiles qui ne présentent pas cette caractéristique. Son objectif est de comprendre sur le plan physique les causes de cette variation de rayonnement.

C’est le cas dans les images suivantes :

Fig. 5. (K. Stanek./CfA)

A gauche, une image prise avec un télescope optique d’une zone stellaire comportant des points noirs représentant des étoiles variables et des étoiles non variables.

A droite, l’astrophysicien a soustrait les étoiles non variables de l’image. Il ne reste plus qu’un seul point noir représentant une étoile variable.

La soustraction est réalisée en se rapportant aux différents catalogues célestes. Ces catalogues contiennent les données relatives aux positions des étoiles non variables et c’est à partir d’elles que l’on opère cette soustraction. Il s’agit bien ici à nouveau de retirer des éléments visibles de l’image source pour ne conserver que les objets d’investigation que l’on souhaite étudier, à savoir les étoiles variables. Il s’agit à nouveau d’une transformation optique.

Dans les deux exemples figurant dans les pages qui précèdent, les chercheurs visent à supprimer des données jugées non pertinentes au regard des finalités qu’ils se sont assignées :

-

supprimer des artefacts et du bruit de fond ;

-

isoler dans un champ céleste un objet spécifique.

4.3 Exhiber l’invisible

Comme nous l’avons déjà souligné, les images sources sont celles qui comportent le maximum d’informations sur le plan quantitatif. Leur exploitation est par conséquent difficile en raison de ce qui peut apparaître comme un excès d’informations dès lors que l’on souhaite un degré élevé de précision quant à un paramètre donné. Les chercheurs vont ainsi entreprendre de mettre en relief, autrement dit d’exhiber, certaines informations contenues dans l’image, qu’ils seraient incapables d’identifier spontanément avec autant de précision sans l’aide des traitements d’images.

Voici un premier exemple qui consiste en une :

4.3.1 Extraction d’informations

Ci-dessous figure une image en rayons X d’un jet émis par le quasar PKS 1127-145. A l’intérieur de ce jet, l’astrophysicien a repéré trois noyaux (A, B, C) émettant un rayonnement X plus intense. Afin de quantifier plus précisément ces rayonnements, il a réalisé une image retraitée sous forme de courbe. Cette image retraitée représente le nombre de photons recueillis en fonction de la distance par rapport au cœur du quasar. L’astrophysicien peut ainsi quantifier facilement les flux de photons enregistrés en A, B, C, et constater qu’ils diffèrent, alors que sur l’image source, les rayonnements émis par A, B, C sont presque identiques. L’astrophysicien peut clairement conclure que ce n’est plus le cas dans la courbe.

Fig. 6 Image en rayons X du quasar PKS 1127-145 et courbe afférente (D. Harris / CfA)

Si l’on reprend les catégories du Groupe µ, c’est là une transformation analytique et plus précisément, une discrétisation.

4.3.2 Les fausses couleurs

L’usage des fausses couleurs est très répandu dans les sciences de la nature. Les entités ou les propriétés imagées n’ont souvent au sens strict aucune couleur. Les scientifiques choisissent parfois de laisser leurs images dans des gammes de gris qui présentent l’intérêt d’être plus précises. Mais très souvent, que ce soit en physique des matériaux, en astrophysique ou en pharmacologie, ils préfèrent utiliser des fausses couleurs qui sont d’ailleurs souvent intégrées d’office dans les logiciels permettant les traitements d’image. Deux objectifs principaux sont alors visés :

-

Satisfaire une exigence esthétique dans le cadre d’une publication, ou plus fréquemment, lors de la confection d’un poster. Les posters sont exposés à l’occasion de colloques, parmi beaucoup d’autres, et ont pour finalité d'établir une synthèse de l’état d’une recherche et de permettre d’engager la discussion avec ses pairs. Il s’agit donc d’attirer les regards des autres chercheurs en direction de son poster, et l’adjonction de fausses couleurs participe de cette opération de « séduction » ; elle est renforcée par une mise en page attrayante ;

-

rendre les différences plus perceptibles. Les fausses couleurs sont ajoutées également afin de rendre certaines caractéristiques de l’image plus manifestes. En effet, si les gammes de gris présentent l’intérêt d’offrir une grande précision pour une mesure éventuelle, elles sont parfois trop précises pour être visuellement parlantes.

Prenons comme exemple cette image :

Fig. 7. Image STM représentant l’intensité du courant à la surface d’un film d’aluminium oxydé par technique plasma (V. Da Costa. / GSI).

Le chercheur utilise une gamme de couleurs fortement contrastées afin de mieux percevoir un phénomène, ici une forte intensité du courant (en rouge) toujours corrélée avec une intensité moindre (en vert), et non pas avec une intensité nulle (en bleu). Pour vérifier que cette association de couleurs (entre le rouge et le vert) n’est pas un artefact dû à la colorisation, le physicien a dénombré en recourant à l’ordinateur les pixels correspondant aux différents points et zones colorisés. Il a ensuite réparti ce nombre de pixels de manière aléatoire sur une surface équivalente à celle de départ. Il s’agissait de montrer que l’image colorisée obtenue n’était pas l’effet du hasard. Les trois couleurs très contrastées – rouge, vert, bleu – rendent l’image beaucoup plus parlante et convaincante que si l’image avait été réalisée dans une gamme de gris. Il s’agit d’une transformation optique au sens du Groupe µ.

4.3.3. L’addition : le compositage

Afin d’améliorer leur qualité, les astrophysiciens composent des images en additionnant les données de plusieurs images. De ce fait, les sources célestes qui sont faibles apparaissent plus brillantes et plus nettes. Le but recherché ici est d’améliorer le contraste. Cette technique est particulièrement employée en astrophysique optique. L’astrophysicien peut assembler ainsi jusqu’à plus de 100 images !

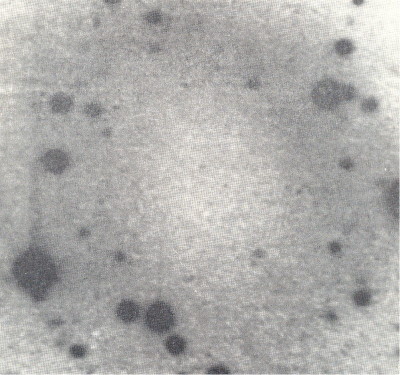

Fig. 8. Image d’un nuage de poussière dans le domaine optique résultant de l’addition de deux images (R. Schild. / CfA).

Il s’agit à nouveau d’une transformation optique.

D’un point de vue téléologique, et si on répertorie les finalités des transformations que nous venons d’évoquer, nous trouvons :

-

gagner en précision dans le cas de la mesure du rayonnement X ;

-

montrer que l’intensité du courant ne se répartit pas de manière aléatoire, mais suit visiblement des lois déterminées ;

-

améliorer le contraste et rendre ainsi perceptible des objets peu visibles, en raison de leur faible rayonnement.

4.4. Exhiber un visible invisible !

Le traitement des images permet également de contourner l’obstacle constitué par certaines limitations instrumentales. Ainsi, la profondeur de champ d’un microscope optique est d’autant plus limitée que le grossissement de l’instrument est plus important. Pour de forts grossissements, on ne pourra effectuer la mise au point que sur une zone très limitée de l’objet observé. Par exemple, sur l’image de droite, la représentation de l’œuf d’Icaricia Lupi est en bonne partie floue, et nette seulement sur une petite partie de l’image. Les logiciels de traitement des images permettent cependant de remédier à cette limitation. Le microscope est programmé pour prendre une série d’images sources (une centaine par exemple) en faisant varier d’un pas constant la distance entre l’objectif et l’objet observé. On obtient une série d’images sources dont chacune fait le point sur un plan différent de l’objet. Un logiciel de traitement des images permet de générer une image finale retraitée qui combine les zones nettes de chaque image et supprime les zones floues. On obtient ainsi une image avec un fort grossissement et une grande profondeur de champ, une image complètement nette comme c’est le cas de l’image de gauche. Le résultat obtenu consiste en une image retraitée que l’utilisateur du microscope ne peut jamais « voir » telle quelle en regardant dans le microscope. Il s’agit bien ici d’exhiber ce qui est visible (l’objet est en l’occurrence de taille macroscopique), mais avec le secours de nos seuls yeux, nous ne pourrions jamais le voir aussi nettement.

Fig. 9. L’œuf d’Icaricia Lupi

Grâce à l’image, il devient ici un hyper visible, ou un visible invisible… D’un point de vue téléologique, la finalité est ici : obtenir une image de l’objet d’étude parfaitement nette. C’est une transformation de type cinétique au sens du Groupe µ.

5. Conclusion

Il existe bien d’autres procédures de traitement des images sources et des données sources permettant d’obtenir des images retraitées, mais ce qui peut être affirmé sur la base des exemples qui précèdent, c’est le caractère opératoire des concepts du Groupe µ, dès lors qu’il s’agit de comprendre en profondeur quels processus permettent de camoufler le visible ou d’exhiber l’invisible dans des laboratoires de science de la nature. Ce sont bien ces types de procédures (géométriques, analytiques, optiques, cinétiques) qui permettent de caractériser les traitements d’image tels qu’ils sont réalisés à bien dans ces laboratoires.

Mais revenons brièvement sur les termes de « camouflage » et d’« exhibition », afin de souligner en quel sens il faut les entendre dans le contexte particulier des sciences de la nature. Camoufler, c’est dérober intentionnellement à la vue. Exhiber, c’est placer sous le feu des projecteurs, et donc présenter à la vue, certains éléments que l’on juge particulièrement importants ou pertinents. Il y a ici une ambiguïté autour de ces termes, ambiguïté que l’on retrouve dans les domaines des sciences de la nature :

-

camoufler, c’est dissimuler ce qui ne doit pas être vu pour des raisons diverses. Si l’on retient ce sens, on peut imaginer par exemple que les scientifiques dissimulent des données pertinentes qui contredisent les conclusions auxquelles ils souhaitent parvenir. Le camouflage entendu en ce sens correspondrait alors à ce que l’on appelle la fraude scientifique que l’on rencontre parfois dans le cours des recherches, et que le contrôle intersubjectif entre pairs a pour fonction de repérer et d’éliminer. Il en va de même pour les procédés consistant à exhiber des éléments d’une image : il est tout à fait possible de concevoir que certains scientifiques « forcent » quelque peu l’interprétation du sens d’une image en accordant artificiellement une importance excessive à certains aspects de l’image (reproche qui est d’ailleurs fréquemment formulé par les relecteurs des revues scientifiques, à propos de certaines images proposées pour une publication – dans le cas du moins des rapports que nous avons eu l’occasion de consulter en physique des matériaux).

-

Le sens du verbe « camoufler » qui convient pour les exemples que nous avons exposés est bien différent : il s’agit bien plutôt d’éliminer sur le plan visuel les données non pertinentes au regard d’une finalité déterminée. Une telle démarche de camouflage présuppose une hiérarchisation des données en vue d’améliorer les conditions de visualisation des données pertinentes – et non en raison d’une intention dissimulatrice. Une telle hiérarchisation des données est également repérable quand il s’agit d’exhiber certains éléments des images, non pas à des fins frauduleuses, mais en vue de faciliter la lecture de l’image en soustrayant des éléments considérés comme inutiles ou parasites. Cette hiérarchisation des données n’est pas établie de manière arbitraire et prend en compte les encyclopédies (au sens du Groupe µ) du chercheur, de l’ensemble du laboratoire et du domaine de spécialité.

Cela dit, si les opérations de camouflage et d’exhibition ont bien droit de cité dans les laboratoires scientifiques, les chercheurs sont conscients du risque de distorsion des informations contenues dans l’image quand ils opèrent des traitements particuliers sur celle-ci. Comme nous l’a indiqué, au cours d’un entretien, un physicien des matériaux : « A chaque transformation, on risque une perte d’information ou un rajout d’information. ». Par conséquent, toute l’entreprise des scientifiques consiste à développer des stratégies visant à réduire ce risque, inhérent à la production des images et aux traitements que nous avons présentés sous la forme de quelques exemples. L’erreur involontaire est toujours possible et relativement fréquente dans les faits. Ceci permet de comprendre pourquoi l’ambition des scientifiques est de constituer un câble peircien dont les fibres croisées garantissent la solidité.

Etablir un tel câble suppose que l’on croise les résultats obtenus grâce au recours à :

-

des stratégies expérimentales telles que la calibration des instruments, le recours aux statistiques, l’interinstrumentalité (c’est-à-dire le recours à plusieurs instruments reposant sur des principes physiques différents), etc.

-

la cohérence avec les théories admises ;

-

des simulations ou des prédictions calculées.

C’est en développant ces stratégies expérimentales que les chercheurs tentent d’éliminer les risques d’erreurs liées au travail sur les informations contenues dans les images. « Camouflage » et « exhibition » sont ainsi l’aboutissement d’opérations conscientes en matière de traitements d’images sources, qui ne vont pas sans les risques précités – mais qui représentent une part importante du travail mené au quotidien dans les laboratoires œuvrant au sein des sciences de la nature.