Objectivité et images scientifiques : une perspective sémiotique

- Note de bas de page 1 :

-

Hacking, 1999/2001, p. 23 / 41.

- Note de bas de page 2 :

-

« Comparez quelques dictionnaires courants. On pourrait difficilement croire que le mot ‘fait’ tel qu’il est défini dans le Webster New Collegiate est le même mot que celui qui est défini dans le dictionnaire Collins. La définition dans l’American Heritage Dictionary commence par : 1) Information présentée comme objectivement réelle. Les deux derniers mots ne posent pas problème, mais la définition éclate littéralement avec l’adjectif ‘présenté’ – veut-on dire que quelque chose pourrait constituer un fait simplement parce que ce quelque chose est présenté comme objectivement réel ? Le dictionnaire New Shorter Oxford donne comme sens de ‘réel’, ‘ce qui est réellement et effectivement le cas’. », p. 23/41. (traduction modifiée).

Ma visée centrale dans le cadre du présent article consistera à me pencher sur la définition du mot « objectivité », un « mot-ascenseur » (« elevator word »), pour reprendre l’expression employée par Ian Hacking dans La construction sociale de quoi ?1, à propos des mots « vérité » ou « réalité ». Les mots-ascenseurs sont ainsi qualifiés parce qu’ils fonctionnent à un autre niveau que les mots désignant les idées ou les objets. Ils « élèvent » en quelque sorte le niveau du discours philosophique. Ils ont par ailleurs deux caractéristiques, toujours selon Hacking. Premièrement, leur définition est le plus souvent circulaire2. Deuxièmement, ils ont connu des modifications substantielles de sens et de valeur au cours de l’histoire. C’est pour contribuer à rompre cette circularité et pour souligner son historicité que je vais aborder le mot « objectivité » en souscrivant à l’approche esquissée par Hilary Putnam dans la proposition suivante :

- Note de bas de page 3 :

-

Putnam, 2003, p. 142.

Dans la pratique scientifique, les questions relatives à l’objectivité ne sont pas des questions de métaphysique, mais des questions qui concernent le caractère que présentent certaines thèses défendues dans des recherches particulières.3

Conformément à une telle approche, je partirai de la considération de pratiques scientifiques effectives, historiquement et socialement situées. Plus précisément, j’essaierai de voir en quoi l’objectivité constitue une méta-norme épistémique en prenant pour point de référence les pratiques qui ont trait à la production d’un type de résultats déterminés, les images scientifiques.

- Note de bas de page 4 :

-

Rebecca Kukla (2008) définit ainsi ce qu’elle entend par une « appréhension naturaliste de l’objectivité ». Celle-ci « (a) présuppose que les jugements objectifs – jugements qui constituent véritablement la cause de notre conception du monde tel qu’il est réellement – existent et sont le but visé par maintes pratiques épistémiques, plutôt que d’essayer de produire un argument transcendantal prouvant la possibilité de l’objectivité ; (b) étudie l’objectivité en analysant des pratiques empiriques déterminées, historiquement et socialement situées, en vue de dégager leurs standards internes, plutôt que de développer d’abord un point de vue abstrait sur l’objectivité, à partir duquel mesurer les pratiques épistémiques particulières. » (p. 287, traduction personnelle). Les recherches menées par Daston et Galison s’inscrivent éminemment dans un tel cadre comme en attestent les lignes suivantes extraites de leur ouvrage Objectivity : « Ceci est une conception de l’objectivité constituée à partir de la base (bottom up), plutôt qu’à partir du sommet (top down). C’est en accomplissant certaines actions, encore et encore – pas seulement des manipulations physiques, mais également des exercices spirituels – que l’objectivité en vient à exister. On devient objectif en accomplissant des actes objectifs. Au lieu d’un idéal préexistant appliqué au monde du travail quotidien, c’est là l’autre terme de l’alternative : l’idéal et l’ethos sont progressivement développés et prennent corps grâce à des milliers d’actions concrètes. » (p. 52, traduction personnelle). Voir également sur ce point Galison, 1999, p. 16, lorsqu’il évoque l’opportunité de considérer la question de l’objectivité du point de vue dont on dispose en prenant appui sur la terre ferme des pratiques (a ground-floor view of scientific practice …), plutôt qu’en la traitant comme un problème philosophique abstrait.

- Note de bas de page 5 :

-

Galison, 1998, p. 329.

- Note de bas de page 6 :

-

Daston, 1998, p. 371.

Lorsqu’on se dote d’un tel cahier des charges, on ne peut manquer de rencontrer dans le cours de ses investigations un important ensemble de travaux réalisés par Lorraine Daston et Peter Galison, travaux qui ont trouvé leur point d’orgue avec la parution de l’ouvrage Objectivity en 2007. Ces auteurs ont développé, durant ces deux dernières décennies, une approche naturaliste4 des stratégies représentationnelles déployées depuis la Renaissance dans les différents domaines des sciences expérimentales. Plus précisément, ils ont distingué trois grands moments dans la vaste entreprise collective visant à représenter scientifiquement les multiples facettes de la nature. A ces trois moments correspondent trois types d’images distincts : l’image métaphysique tenue pour « aussi vraie que nature », l’image mécanique, l’image interprétée5. Le développement successif de ces trois types ne suppose aucun progrès dans le passage de l’un à l’autre, mais bien plutôt un changement de régime quant aux normes que les scientifiques s’imposent de respecter, tout en les imposant simultanément à leurs pairs. Ces normes relèvent de plusieurs ordres : principes épistémologiques, contraintes pratiques, obligations morales. A l’intention du lecteur qui serait surpris de voir ainsi apparaître des obligations morales dans le champ de la science, Daston et Galison pointent du doigt l’ascèse que constitue par exemple pour les savants la réalisation d’images photographiques à compter des années 1830. De la part de celui dont la subjectivité doit s’effacer du résultat final sont ainsi exigées l’humilité, le renoncement à soi et à sa propre vanité6.

Comme on peut le constater en lisant les textes programmatiques rédigés au fil des siècles par des auteurs que Daston et Galison citent abondamment, les trois stratégies représentationnelles (la véracité de la nature, l’objectivité mécanique, le jugement exercé) se développent sur un fond d’idéaux et avec l’espoir à chaque fois renouvelé d’avoir enfin trouvé le type d’images qui rendrait pleinement compte de la nature des phénomènes étudiés. Comme on pouvait s’y attendre, idéaux et espoirs ont été régulièrement déçus. Cela se comprend aisément dès lors qu’on prend en considération les limitations inhérentes à tout dispositif d’enregistrement des données issues du réel.

Les trois directions que je vais successivement emprunter dans le présent article peuvent se décliner ainsi : tout d’abord, je souhaiterais montrer que l’analyse de l’histoire de la production des images scientifiques depuis la Renaissance, telle que la proposent Daston et Galison, avec son découpage ternaire, peut être éclairée à partir d’un angle de vue légèrement différent, celui qu’offre la sémiotique d’inspiration peircienne. Dans un deuxième temps, je voudrais souligner le fait que la perspective adoptée par Daston et Galison qui reste essentiellement génétique (comment les images sont-elles produites ?) tend peut-être à occulter ce qu’une perspective téléologique quant aux mêmes types d’images (en vue de quoi sont-elles produites ?) permettrait en revanche de mettre en relief : à savoir que les trois stratégies représentationnelles qu’ils distinguent coexistent et restent appropriées aujourd’hui aux finalités des recherches menées dans certaines disciplines des sciences expérimentales. Tout dépend de la nature des phénomènes que les chercheurs visent à représenter et des fonctions particulières qu’ils assignent aux représentations visuelles obtenues. Les impératifs qui sont les leurs varient ainsi en vertu de facteurs multiples, parfois hautement spécifiques et propres à une discipline déterminée. Dans un troisième et dernier temps, j’aimerais revenir très brièvement sur la définition du mot « objectivité » afin de constater que son champ d’extension inclut un grand nombre de pratiques non réductibles aux opérations constitutives de « l’objectivité mécanique », telle que la caractérisent Daston et Galison. Je tenterai de montrer que bon nombre de démarches et de procédures expérimentales, standardisées ou non, contribuent au sein des laboratoires, à la réalisation d’images que les chercheurs sont en droit de considérer jusqu’à nouvel ordre comme étant objectives.

1. Aspects méthodologiques

En quoi la sémiotique peut-elle contribuer à mieux comprendre les distinctions opérées par Daston et Galison dans le cadre de leur approche diachronique des images scientifiques ? Cette question s’est posée à moi alors que je venais de concevoir une typologie des images scientifiques dans le cadre d’une approche synchronique. Les différentes catégories figurant dans cette typologie semblaient pouvoir s’ajuster au découpage ternaire proposé par les deux historiens des sciences. La perspective qui était la leur coïncidait avec la mienne. C’est une perspective que l’on peut qualifier de génétique. Il s’agissait en effet de partir des questions : comment les images sont-elles produites ? Avec quelles contraintes imposées par l’objet d’étude et par le dispositif imageant ?

Avant d’aborder le point central de cette première partie de l’article, il me faut fournir quelques précisions préalables. Je vais d’abord présenter brièvement le laboratoire dans lequel j’ai pu me livrer aux observations qui ont constitué le matériau empirique à partir duquel j’ai conçu ma typologie. Je formulerai ensuite quelques précisions d’ordre terminologique quant aux images et je préciserai les emprunts que j’ai faits à la sémiotique de Charles Sanders Peirce.

- Note de bas de page 7 :

-

Le Groupe Surfaces-Interfaces a été rebaptisé depuis Département Surfaces-Interfaces- DSI.

Ma réflexion se nourrit d’études ethnographiques de terrain que j’ai réalisées depuis 1999, dans des laboratoires de physique des matériaux, d’astrophysique et de pharmacologie. Dans les pages qui suivent, je restreindrai le champ de mes exemples à la production et à l’exploitation des images telles que ces activités ont cours en physique des matériaux. J’ai eu l’occasion de séjourner environ six mois dans un laboratoire à Strasbourg, le Groupe Surfaces-Interfaces ou GSI7. Les chercheurs y consacrent l’essentiel de leur activité à l’étude des structures et des propriétés des surfaces de matériaux. Pour ce faire, ils recourent à de nombreux instruments et en particulier à des microscopes, qui fonctionnent grâce à des rayonnements électromagnétiques ou à d’autres effets physiques, comme l’effet tunnel. Les échantillons de taille millimétrique que j’évoquerai revêtent d’ordinaire l’aspect de dépôts métalliques sur des substrats métalliques (par exemple, un dépôt de nickel sur du cuivre).

1.1 Définition du concept d’image

- Note de bas de page 8 :

-

Pour plus de précisions ces aspects méthodologiques, cf. Allamel-Raffin, 2004a, 2009.

Mon objet d’étude privilégié étant constitué par l’image scientifique, j’ai élaboré une définition de cette dernière afin de pouvoir mieux cerner au sein du laboratoire Groupe Surfaces-Interfaces les types d’objets qui seraient susceptibles de s’inscrire de manière pertinente dans le champ de mon analyse et ceux qu’il conviendrait d’exclure : c’était là une étape essentielle de mon travail ethnographique8.

J’entends par image toute représentation visuelle bidimensionnelle analogique ou symbolique, sur un support matériel (papier ou écran).

Le sens des termes « représentation », « analogique » et « symbolique » exige d’être précisé, tant leur polysémie est grande.

-

Toute « représentation » consiste en un objet second, matériellement distinct de ce qu'il représente conformément à la conception développée par Umberto Eco (1997/1999, p. 354). Précisons que l'objet représenté n'est pas nécessairement matériel – il peut s'agir d'une entité abstraite ou fictive.

-

Par « analogique », il faut comprendre ici toute relation de similarité entre la représentation et le représenté. On peut distinguer sur ce point deux types :

-

La relation d'isomorphisme (la représentation a la même forme que le représenté ; (ibid., p. 355) ;

-

la relation d'homomorphisme (la représentation conserve certaines propriétés structurelles du représenté ; ibid., p. 355). Cela nécessite la mise au point de règles régissant et légitimant le choix de certaines propriétés qu'on va conserver au détriment d'autres.

-

- Note de bas de page 9 :

-

De telles affirmations ont été longuement discutées. On s’est interrogé, notamment dans le cadre du débat qui oppose naturalistes et conventionalistes, sur la part exacte de convention en jeu dans le cas de la perspective. Pour un conventionaliste tel que Nelson Goodman, il va de soi que la perspective « ne fournit pas de norme de fidélité qui soit absolue ou indépendante » de conventions déterminées (Goodman, 1968, p. 46). Pour éprouver la pertinence de telles déclarations, les philosophes participant au débat se sont parfois tournés du côté de l’anthropologie. En effet, de nombreuses expériences ont été menées au cours de ces dernières décennies, par des anthropologues, consistant à donner aux membres de tribus « innocentes sur le plan de la dépiction » des dessins qu’on leur demandait dans un second temps de commenter. Ce fut le cas récemment avec une tribu éthiopienne, les Me’en (Prinz, 1993, p. 1). Des trois images qu’on leur a présentées, les Me’en ont pu identifier les deux qui représentaient des animaux qui leur étaient familiers, un cerf et un léopard (souvent en reconnaissant d’abord un élément particulier de leur anatomie – pattes, cornes, etc.). En revanche, ils n’ont pas réussi à repérer l’effet de perspective présent dans la troisième image représentant une scène de chasse.

Le caractère analogique n'est donc pas limité à la ressemblance perceptive (isomorphisme au sens d’Umberto Eco). Ainsi, une image numérique ne perd pas sa dimension analogique du point de vue sémiotique : une image graphique, par exemple un histogramme, reste analogique puisqu'elle convertit en variables visuelles discontinues des grandeurs numériques, selon des règles de proportion. La notion de règle de similarité homomorphique est essentielle : elle permet de saisir le rôle déterminant de l'apprentissage en matière de lecture d'images (cet apprentissage pouvant être tacite). On peut considérer que certaines règles se sont en effet imposées collectivement, de telle sorte qu'elles sont intégrées spontanément à la lecture d'une image donnée. En guise d'exemple canonique, songeons simplement à la convention de la perspective, telle qu'elle fut formalisée au XVe siècle par L. B. Alberti (M. Mercier, 1991 ; p. 28). Son acceptation par tous en Occident a eu pour conséquence notoire le fait qu'une image que nous visualisons, qui respecte la convention, produit un « effet de réel » sur le spectateur9. D'autres règles de similarité homomorphique sont bien évidemment moins diffusées socialement, en particulier celles que je serai amenée à évoquer dans les pages qui suivent.

-

Par « symbolique », j’entends tout rapport conventionnel permettant d’établir un lien entre une représentation et ce qui est représenté.

1.2 Les types d’images produites en physique des matériaux

La typologie qui suit a été élaborée au cours de séjours au GSI. Sa pertinence a ensuite été éprouvée en appliquant les catégories constituées aux images produites dans des laboratoires d’astrophysique et de pharmacologie. L’observation des pratiques de recherche quotidienne m’a incitée à établir une distinction entre « image source » et image « retraitée ». L’« image source » est l'image matérielle produite avec un microscope. Elle est conçue par les scientifiques comme le résultat d'une interaction entre plusieurs éléments : l’échantillon, la source de rayonnement (ondes électromagnétiques, effet tunnel, etc.) et le dispositif « imageant ». L’« image source » est la première dans l’ordre chronologique de production des images.

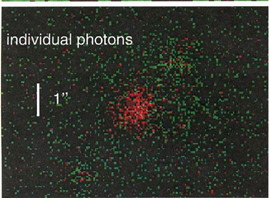

Fig. 1 Image source STM. C. Boeglin/DSI

Voici une image source produite avec un microscope à effet tunnel (STM). Il s’agit d’alignements d’îlots de CoPd (alliage de cobalt et de palladium) déposés sur une surface d’or.

L’image retraitée, quant à elle, est élaborée à partir de l’image « source ». Elle ne retient que certaines informations contenues dans l’image source et peut revêtir diverses formes : courbes, images filtrées, etc.

Fig. 2 Image source STM + image retraitée C. Boeglin/DSI

Ici, nous avons la même image STM que précédemment. Nous voyons des taches de couleur allant du jaune au rouge, représentant les différentes hauteurs de ce qui est à la surface de l’échantillon. Pour avoir une mesure beaucoup plus précise de ces variations de hauteur, le chercheur choisit deux points à l’intérieur de l’échantillon. Il trace une ligne virtuelle en noir entre ces deux points et obtient le relief correspondant à l’espace compris entre ces derniers : c’est cette courbe qui constitue ce que j’appelle l’image « retraitée ».

Enfin, l’observation de l’activité des chercheurs dans ces laboratoires m’a conduite à élaborer une troisième catégorie : les images de « synthèse ». Celles-ci sont réalisées à partir de programmes informatiques uniquement, c’est-à-dire qu’elles reposent dans le cadre de leur production que sur l’utilisation exclusive d’algorithmes.

À partir de ce qu’il était possible de collecter en matière d’images au sein du laboratoire, j’ai donc pu dégager trois types d’images : images « sources », images « retraitées », images de « synthèse », sans avoir de garantie quant à la représentativité et l’exhaustivité d’une telle collecte et d’une telle catégorisation. Une fois cette classification établie sur la base des procédures permettant de les produire, dans le cadre d’une perspective génétique, il fallait encore préciser la nature des liens qui s’établissent entre les images et les objets d’étude qu’elles sont censées représenter, à savoir des échantillons de matériaux (des métaux déposés sur des substrats métalliques) ou les propriétés de ces échantillons. Afin de répondre à cette question, j’ai eu recours aux ressources offertes par la sémiotique de Charles Sanders Peirce.

2. La sémiotique de Charles Sanders Peirce

- Note de bas de page 10 :

-

De nombreuses études ont consisté à exporter les catégories de la sémiotique peircienne dans des domaines divers, par exemple les travaux de P. Boudon (1971) dans le cadre de l’architecture ou ceux de N. Everaert-Desmedt consacrés au récit (1988). En ce qui concerne le domaine scientifique, I. Babou (1999) propose dans sa thèse une perspective peircienne sur les discours médiatiques relatifs à la vulgarisation.

Les lignes qui suivent n’ont pas pour fonction de proposer une exégèse détaillée de l’œuvre de C. S. Peirce. De très nombreux auteurs se sont livrés à une telle entreprise, en particulier dans le domaine anglophone. Pour m’en tenir aux publications françaises ou transalpines : U. Eco (1970 ; 1972 ; 1980 ; 1992), R. Jackobson (1973), É. Benveniste (1974), G. Deledalle (1978 ; 1979 ; 1994), le Groupe µ (1992), N. Everaert-Desmedt (1990 ; 1994), C. Tiercelin (1993a, 1993b), R. Marty et C. Marty (1992), I. Babou (1999, 2006). Je m’appuierai brièvement sur les écrits de C. S. Peirce lui-même et sur l’ensemble de ces ouvrages, pour tenter de justifier dans un premier temps le choix d’un tel cadre d’analyse. Dans un second temps, je tenterai d’appliquer les catégories de cette sémiotique à l’étude des représentations visuelles analogiques ou symboliques produites dans un laboratoire de physique des matériaux. Ce faisant, il ne s’agira pas pour moi de me livrer à un exercice académique un peu vain, destinée à entrevoir la pertinence de la sémiotique peircienne dans un cadre inédit10. J’espère montrer que cette sémiotique permet d’éclairer deux points particulièrement cruciaux dès lors qu’on aborde la question des images dans un laboratoire de physique expérimentale : la nature très particulière de ces images en ce qui concerne leur production, et le type de dynamique à l’œuvre au cours du processus de recherche.

2.1 Pourquoi se référer à la sémiotique peircienne ?

a) une sémiotique triadique

- Note de bas de page 11 :

-

Selon J. Davallon (1993), la définition du signe proposée par C. S. Peirce est plus ouverte et plus dynamique que celle proposée par F. de Saussure. Ceci explique peut-être les marques d’intérêt relativement récentes en France pour le premier, après un XXe siècle qui a vu le triomphe de la linguistique saussurienne, fonctionnant comme modèle au sein des sciences humaines. J.-J. Boutaud affirme sur ce point, reprenant B. Darras : «…il est vrai que l’espace sémiotique s’est longtemps trouvé réduit entre une sémiotique d’inspiration structurale, autour du parcours génératif que nous avons décrit, et une sémiotique interprétative, d’inspiration peircienne, qui se trouve aujourd’hui ravivée par la mise en perspective de la fameuse trichotomie icône – indice – symbole » (1998 ; p. 223).

- Note de bas de page 12 :

-

L’édition des œuvres de C. S. Peirce pose un réel problème aux éditeurs en raison de l’immensité du corpus (douze mille pages imprimées du vivant de l’auteur, et quatre-vingt mille pages manuscrites). Aux Etats-Unis, il y a eu une grande édition des œuvres de C. S. Peirce, « The Collected Papers » effectué par les Presses de l’Université de Harvard. Parue entre 1931 et 1958, cette édition comprend huit volumes. Un nouveau projet d’édition des œuvres complètes a vu le jour en 1982 sous la responsabilité éditoriale de M. H. Fisch. Ce projet devrait permettre la parution de trente volumes. A ce jour, six volumes ont déjà été édités. En France, le travail de G. Deledalle (1978) et celui de J. Chenu (1984) ont permis de promouvoir cet auteur. C. Tiercelin et P. Thibaud (2002 ; 2003) ont entrepris récemment de publier des parties de l’œuvre intégrale de C. S. Peirce en traduction française. Ces éditeurs ont pour ambition de faire paraître dix volumes, sans s’imposer un impératif de publication exhaustive de l’œuvre peircienne. Les promoteurs de cette nouvelle traduction ont été, eux aussi, contraints d’effectuer des choix au sein de ce corpus immense.

La sémiotique peircienne11 offre un cadre conceptuel permettant de penser les images et les aspects du réel qu’elles représentent, en dépit de sa complexité parfois déroutante (rappelons qu’« on a pu relever dans les manuscrits de C. S. Peirce au moins soixante-seize textes plus ou moins définitoires du signe », R. Marty et C. Marty, 1992 ; p. 38). Cette complexité découle pour partie du fait que C. S. Peirce lui-même n’a pas donné une forme achevée à ses travaux de sémiotique, menés tout au long de son existence. De surcroît, la démarche des éditeurs successifs a consisté à assembler des fragments en les regroupant par thèmes, jugés pertinents selon leurs propres critères. D’où l’apparente incohérence de l’ensemble12.

- Note de bas de page 13 :

-

Les définitions du signe sont bien sûr innombrables depuis l’Antiquité. U. Eco se livre à une étude historique de la notion, en déplorant la diversité de ses emplois (Eco, 1984/1988).

La sémiotique peircienne peut constituer une base de travail utile, car elle est fondamentalement triadique. Elle permet d’étudier les relations qui se nouent entre le signe (ou representamen), l’objet et l’interprétant. Voici une définition du signe qui nous servira de point de départ13 :

Un signe, ou representamen, est quelque chose qui représente à quelqu’un quelque chose sous quelque rapport (respect) ou à quelque titre (capacity). Il s’adresse à quelqu’un, c’est-à-dire, crée dans l’esprit de cette personne un signe équivalent, ou peut-être plus développé. (C. S. Peirce, 1978 : 2.228 ; p. 121).

En d’autres termes, le signe est quelque chose qui est mis à la place d’autre chose pour un esprit. Le fait que Peirce n’a pas jugé bon d’« évacuer » le référent du champ de son analyse (comme le font F. de Saussure et sa descendance), s’avère fondamental dans le cadre d’une étude des productions écrites ou visuelles réalisées au sein des sciences expérimentales. En effet, ces dernières ne visent pas seulement à construire un discours cohérent à propos de leurs divers objets d’études. La démarche scientifique a pour ambition de parvenir également à une maîtrise, au moins relative, de ses objets d’étude, c’est-à-dire à obtenir des effets concrets sur les objets étudiés. Ceci est notamment valable pour la physique des matériaux. Il s’agit pour les membres du GSI de mieux comprendre les phénomènes physiques qui régissent les interactions à l’échelle nanométrique entre deux types de matériaux. Il s’agit également de les maîtriser : l’une des ambitions des chercheurs est de pouvoir fabriquer des matériaux qui auront certaines propriétés, afin de les développer et de les utiliser éventuellement dans un cadre industriel. Ils n’ont accès à leurs objets d’étude qu’au travers de représentations visuelles analogiques ou symboliques. Toute étude portant sur ces images devra prendre en compte l’objet qu’elles sont censées représenter.

b) le pragmatisme

- Note de bas de page 14 :

-

Comme en témoigne le titre de l’un des deux articles de « La logique de la science » (1878), intitulé : « Comment rendre nos idées claires » (publié dans les recueils français élaborés par J. Chenu, 1984, et C. Tiercelin et P. Thibaud, 2002).

La sémiotique de Peirce est indissociable du cadre philosophique que constitue sa version du pragmatisme, en tant que méthode de clarification conceptuelle14. Celle-ci, selon la célèbre maxime pragmatiste peircienne, consiste à « considérer quels sont les effets pratiques que nous pensons pouvoir être produits par l’objet de notre conception » (5.402). D’après J. Chenu, une telle démarche « consisterait à rechercher le sens d’une hypothèse ou de n’importe quelle idée, dans ses conséquences pratiques, sans autre spécification » (1984 ; p. 149). Encore faut-il ne pas se méprendre sur le sens à conférer à de telles formules. Le pragmatisme de C. S. Peirce s’applique bien à l’action et à la pratique, mais il s’agit ici d’entendre « action » et « pratique », non pas dans un sens restreint, mais comme « action » et « pratique » « conçues ». Ce dernier point est important, car il a été la source selon C. Tiercelin de bien des malentendus.

En résumé, la maxime pragmatiste n’a rien d’un principe matérialiste ou nominaliste : elle se présente comme une méthode d’élucidation de nos concepts, lesquels ne peuvent être compris que par référence à des croyances, bref à des dispositions générales à agir qui se manifestent dans des actions inséparables d’une visée rationnelle. (Tiercelin, 1993a ; p. 34).

Il faut donc inscrire dans le cadre d’une telle philosophie pragmatiste l’affirmation selon laquelle la signification d’un signe est ce qu’il fait, comment il agit sur l’interprète, quel effet il produit :

Décrire la signification d’un signe, c’est décrire le processus cognitif par lequel le signe est interprété et provoque un type d’action. (…) La démarche interprétative conduit l’interprète de la perception à l’action, par le biais de la pensée. (N. Everaert-Desmedt, 1990 ; p. 29 ; souligné par l’auteur).

Ce type de considération rend bien compte de l’activité menée au sein des laboratoires que nous avons retenus. Il s’agit bien à partir de données fournies par des perceptions (médiatisées par des instruments) de parvenir à l’action (l’élaboration de modèles théoriques, la réalisation concrètes d’échantillons répondant à des qualités physiques précises, etc.) par le biais de la pensée (en s’appuyant sur toutes les théories physiques disponibles à notre époque).

c) une sémiotique triadique et pragmatiste conçue par un scientifique expérimentateur.

C. S. Peirce fut un des derniers savants à propos desquels on peut parler de savoir encyclopédique. Il fut mathématicien, philologue, logicien, physicien, chimiste, astronome, philosophe et, par-dessus tout, sémioticien :

Sachez que depuis le jour où à l’âge de douze ou treize ans, je ramassais dans la chambre de mon frère aîné un exemplaire de la Logique de Whately et lui demandais ce qu’était la Logique et où, ayant reçu une réponse simple, je me jetais sur le sol et me plongeais dans sa lecture, il n’a plus jamais été en mon pouvoir d’étudier quoi que ce fût – mathématiques, morale métaphysique, gravitation, thermodynamique, optique, chimie, anatomie comparée, astronomie, psychologie, phonétique, économie, histoire des sciences, whist, hommes et femmes, vins, métrologie, si ce n’est comme une étude sémiotique. (C. S. Peirce, 1978 ; p. 58)

La sémiotique peircienne a été élaborée de manière à rendre compte de tous les types de signes, permettant d’envisager ainsi tous les types d’objets, quels qu’ils soient. Pour C. S. Peirce, penser, c’est manipuler des signes de manière à fixer une croyance qui déterminera nos dispositions à agir. Par croyance, il entend : « …quelque chose sur la base de quoi un homme est prêt à agir : c’est par conséquent en un sens général, une habitude. » (C. S. Peirce, 2.148, cité par C. Tiercelin, 1993a ; p. 84).

- Note de bas de page 15 :

-

Nous n’entrerons pas dans le débat esquissé par C. Tiercelin (1993a) quant au nombre de méthodes permettant de fixer une croyance, ou encore sur les qualités prêtées par C. S. Peirce à la méthode scientifique. Notre objectif est ici non pas de nous livrer à un exercice critique de la pensée peircienne, mais plutôt d’envisager ce cadre sur un mode opératoire nous permettant de mieux cerner l’objet d’étude constitué par les images scientifiques.

- Note de bas de page 16 :

-

Sur ce point, voir Allamel-Raffin 2004a, 2004b.

Or, C. S. Peirce va montrer dans son article The Fixation of Belief, que la méthode scientifique est supérieure à d’autres méthodes pour fixer la croyance, ces autres méthodes étant la ténacité, l’autorité et la méthode a priori. La méthode scientifique permet d’établir une croyance stable. Les résultats produits par cette méthode scientifique qui repose sur l’observation et le raisonnement dépassent largement le cadre privé d’une croyance particulière, puisqu’ils ont un caractère public et ont pour condition nécessaire un accord intersubjectif au sein de la communauté scientifique15. C’est donc bien en fonction d’un arrière-plan scientifique que C. S. Peirce a conçu sa théorie sémiotique, même si cette dernière ne vise pas uniquement à rendre compte des processus de signification dans un tel cadre. C’est pourquoi il me semble judicieux de recourir aux concepts peirciens afin d’explorer un type de représentations particulières : les images scientifiques. Peirce établit trois trichotomies qui lui permettent d’étudier l’ensemble des signes existants. Il faudrait exploiter les ressources offertes par les trois trichotomies et on pourrait alors voir comment le processus de sémiose se déploie et évolue au cours d’une activité expérimentale donnée16. Pour la présente réflexion sur l’objectivité, je vais recourir essentiellement à la deuxième trichotomie, centrée sur la relation entre l’objet et le representamen. Dans ce cadre-là, un signe peut être appelé icône, indice ou symbole.

…l'icône se rattache à l'objet par ressemblance (…). Un indice sera rattaché à l'objet existentiellement en en étant un effet, comme la fumée est un effet du feu et signifie par là l'existence d'un feu à l'endroit où celui-ci apparaît. Enfin, un symbole est rattaché à son objet par une règle qui a pour effet de dire qu'il ‘doit’ être interprété comme signifiant cet objet (par exemple, les parties conventionnellement signifiantes du discours humain). (C. Tiercelin, 1993a ; p. 67).

Les images produites au GSI peuvent évidemment être considérées comme des signes au sens de Peirce : elles sont bien « quelque chose » (une représentation visuelle analogique ou symbolique) mis à la place d’un autre « quelque chose » (un échantillon constitué de matériaux ou des formules mathématiques) pour « l’esprit » des scientifiques. Interrogeons-nous maintenant sur la nature de ces images-signes produites au sein du laboratoire, en référence aux divisions établies par Peirce dans le cadre de sa deuxième trichotomie. Sont-elles indiciaires ? Iconiques ? Symboliques ?

- Note de bas de page 17 :

-

Des auteurs ont déjà considéré, de par le passé, une telle notion de mixité comme pertinente : R. Jakobson reconnaît l’existence de signes mixtes « icône symbolique » et « symbole iconique » (Jakobson, 1973, tome 2, p. 94). La mixité n’est pas une notion développée par Peirce lui-même, qui va jusqu’à souligner qu’en fonction de la situation d’interprétation, un même objet peut être compris comme étant tour à tour un indice, une icône, un symbole. Par exemple, la trace de pas retrouvée par Robinson sur le sable (Peirce, 4.531, cité par Tiercelin, 1993a, p. 55), peut être considérée comme un indice, celui de la présence sur l’île d’un individu particulier, Vendredi ; comme une icône car « ses qualités ressemblent à celles de cet objet et provoquent des sensations analogues dans l’esprit pour lequel il fait ressemblance » (Peirce, 2.299, 1978 ; p. 164), elle ressemble à d’autres empreintes de pas ; comme un symbole pour celle ou celui qui infère de la représentation de cette forme et de ce qu’elle indique, la présence de l’Homme sur l’île (comme l’empreinte de pas de Neil Armstrong peut être considérée comme le symbole du passage de l’homme sur la Lune). Les catégories ne sont donc pas étanches pour Peirce, et en un sens, tous les signes sont mixtes, vus sous l’angle des possibilités d’interprétations auxquelles on peut se livrer à leur propos. Il me semble que, pour se révéler véritablement opératoires dans le cadre qui est celui du moment où les scientifiques produisent des images, on a intérêt à réifier, du moins provisoirement, ces catégories : c’est à cette condition que la notion de mixité acquiert son épaisseur, en ce qu’elle permet de différencier les images en fonction de leurs natures durant la phase de leur production au sein des laboratoires.

-

Les images sources, contrairement à ce que l’on pourrait penser hâtivement, ne sont pas des icônes, car on ne peut établir de ressemblance avec les phénomènes étudiés qui sont, à cette échelle, invisibles, en vertu de leur nature même (ils se situent en-deçà du seuil de la lumière visible). Les images sources produites avec les microscopes du GSI sont mixtes17 : à la fois indices et symboles. Elles sont indiciaires, car elles possèdent un ensemble de qualités que possèdent aussi leurs objets en vertu d’une connexion causale. Ces images sources sont le résultat que l’on obtient au terme des interactions entre des rayonnements électromagnétiques ou l’effet tunnel d’une part, et les échantillons de matériaux d’autre part. Toute modification intervenant dans la chaîne d’interactions affecte l’image obtenue au bout de la chaîne. Les images sources sont également partiellement symboliques car pour les obtenir, il ne suffit pas de disposer de microscopes. Il faut simultanément recourir à un dispositif imageant, c’est-à-dire à un ordinateur fonctionnant comme une boîte noire, ce qui suppose un codage informatique sous forme d’algorithmes.

-

Les images retraitées sont, elles aussi, de nature mixte : indiciaires et symboliques. Indiciaires, car elles sont directement affectées par toute modification éventuelle subie par l’échantillon. Ainsi, dans le cas d’une courbe réalisée à partir d’une image source, comme celle qui est constituée par la figure 2, la courbe sera modifiée si l’on intervient sur l’échantillon. Elles sont d’autre part symboliques, car les traitements spécifiques qui permettent de les réaliser se font au moyen de programmes informatiques.

-

Les images de synthèse, quant à elles, sont de nature symbolique, car elles sont produites uniquement à l’aide d’algorithmes, via des ordinateurs.

- Note de bas de page 18 :

-

Cette partie de mon article est en partie inspirée d’un article déjà paru (Allamel-Raffin, 2006).

3. Mise en perspective historique18

La typologie présentée dans les lignes qui précèdent peut être exploitée dans le cadre d’études exclusivement synchroniques. Mais il est possible de lui conférer une profondeur historique. Cela permet de constater que la typologie permet de rendre compte de l’évolution du statut sémiotique des images scientifiques au fil des siècles, depuis la Renaissance. Cette évolution du statut sémiotique va de pair avec une évolution parallèle des techniques et des manières de concevoir la production des images scientifiques, c’est-à-dire avec un ensemble de normes épistémiques, pratiques et morales qui s’entrecroisent et définissent à chaque époque un idéal en matière de représentation scientifique. Dans les paragraphes qui suivent, je me référerai principalement au découpage ternaire proposé par Daston et Galison, en prenant pour exemples des images ne figurant pas dans leur propre corpus et en soulignant la spécificité sémiotique des trois types d’images correspondant à leur subdivision.

- Note de bas de page 19 :

-

Pour une étude systématique de ce type d’ouvrages naturalistes, je renvoie à la thèse de Renoud-Labrosse (2008).

Mon premier exemple est emprunté à l’un des multiples traités de naturalistes qui apparaissent dès le XVIe siècle. Ces traités sont abondamment illustrés et ont pour domaine d’objet la botanique, l’astronomie, l’anatomie, etc.19. Les illustrateurs ont pour impératif de représenter le plus fidèlement possible des objets jugés dignes d’intérêt par les savants. Dans les termes de Daston et Galison, il faut que les représentations soient « aussi vraies que nature ». Mais quelles significations peut-on conférer à une telle expression ?

L’image figurant ci-dessous a été réalisée par Pierre Belon. Elle est tirée d’un ouvrage intitulé La nature et la diversité des poissons, avec leurs pourtraicts, représentez au plus près du naturel, parue à Paris, chez C. Estienne en 1555 (p. 129).

Fig. 3 Colfisch, en Angleterre, duquel n’avons vu la tête : car aussi est il apporté de dehors pays, salé, sans aucune tête, P. Belon, 1555. Copyright Musée d’Histoire Naturelle de Nantes.

Comme l’indique Sylvène Renoud-Labrosse (2008, p. 89), Belon intègre dans ses titres des termes-clés destinés à garantir la qualité de ses illustrations : « la vraie peinture et description », « pourtaicts », « representez au plus près du naturel », « les observations ». Tous ces termes et expressions ont pour fonction de souligner ce qui caractérise la démarche qu’il a adoptée tout au long de ses travaux. Mais les significations qu’on peut conférer à ce vocabulaire de la véracité naturelle ne correspondent pas nécessairement aux résonances que ces termes et ces expressions éveillent en nous au début du XXIe siècle. L’aspect le plus frappant de la représentation du poisson réside évidemment dans l’absence de tête. La légende correspondante insiste d’ailleurs sur ce point : « Colfisch, en Angleterre, duquel n’avons vu la tête : car aussi est il apporté de dehors pays, salé, sans aucune tête ». « Aussi vrai que nature » signifie donc d’abord que l’illustrateur n’a pas recouru à son imagination pour suppléer à ce qu’il n’a jamais pu voir de ses propres yeux.

Une telle illustration, lorsqu’on l’intègre dans ma grille d’analyse exposée plus haut, constitue une image source appartenant à la catégorie des icônes. Elle se rattache à l’objet par ressemblance. Elle résulte de l’interaction entre deux éléments :

-

L’objet représenté

-

L’observateur qui réalise l’illustration

Du fait que cette image est une icône, on peut tirer un certain nombre de conséquences en relation avec l’exigence qu’elle soit « aussi vraie que nature ». En effet, les difficultés liées à la production de ce type d’image ressortissent à plusieurs registres :

-

Première difficulté : la réalisation d’une telle représentation iconique est soumise à deux types de contraintes spécifiques que rencontrent non seulement les illustrateurs d’ouvrages savants, mais également les artistes qui sont leurs contemporains. Le premier type de contraintes est celui de la nature des outils et des matériaux disponibles qui réduisent les possibilités d’expression et peuvent par conséquent se révéler plus ou moins adéquats. Comme l’écrit Ernst Gombrich, à propos de la création picturale :

- Note de bas de page 20 :

-

Gombrich (1960) « Le stéréotype et la réalité » in L’art et l’illusion, trad. française, Paris, 2002 ; cité d’après Gombrich (2003), Gombrich : l’essentiel, Paris, Phaidon, pp. 90-91.

Il est clair que l’artiste ne peut reproduire son motif qu’autant que l’instrument et la matière qu’il utilise le lui permettent. Sa technique restreint sa liberté de choix. Les contours et les rapports que note le crayon ne sont pas les mêmes que ceux qu’indiquent le pinceau. Le crayon à la main devant son motif, l’artiste recherchera donc les apparences qui peuvent être dessinées par des lignes – ou, comme nous avons coutume de dire, dans une formulation abrégée : il voit son motif en termes linéaires, tandis que, le pinceau à la main, il le verra en fonction des masses »20.

Le second type de contraintes est celui qui se rapporte à l’habileté technique de l’illustrateur. La capacité à reproduire ce qu’il voit est déterminée en partie par des savoir-faire qui varient grandement d’un individu à l’autre. Cette capacité est liée d’autre part à ce que l’illustrateur voit – et ce qu’il voit dépend en partie de ses attentes, de ses connaissances antérieures, de ses intentions, etc.

- Note de bas de page 21 :

-

Daston et Galison, 2007, p. 70.

- Note de bas de page 22 :

-

Daston et Galison, 2007, p. 105.

-

Seconde difficulté : quels sont les choix, quant à ce qui est représenté, que l’illustrateur doit effectuer, afin que la représentation soit « aussi vraie que nature » ? Toutes les techniques employées visent à la réalisation d’une image ressemblante, et donc d’une icône au sens peircien. Mais la notion de ressemblance elle-même est problématique, au point d’avoir souvent été rejetée comme trop vague par certains philosophes ou historiens de l’art. Ce n’est pas cette critique souvent radicale de la ressemblance (et donc la condamnation de la catégorie de l’icône) qui m’importe ici. Il me semble que la polysémie de la notion de ressemblance permet tout au contraire, dans le présent cadre, de faire ressortir la variété des possibilités que le mode de représentation iconique offre aux savants et aux illustrateurs travaillant à leur service, lorsqu’ils réalisent leurs dessins ou gravures. En effet, sont ressemblants, sous des formes distinctes, aussi bien l’archétype résultant d’une recomposition sur la base de cas particuliers, que le cas singulier exemplaire, ou le cas singulier idéal. Tous trois sont susceptibles de permettre au lecteur de dégager la typicité de l’objet représenté21. Et s’il existe des formes multiples de ressemblance, on comprendra aisément qu’une difficulté corrélative pour les savants et les illustrateurs réside précisément dans le choix de la forme adéquate dans le cadre de leurs réalisations. Ils ne peuvent manquer alors de se poser des questions telles que : faut-il représenter un individu particulier d’une espèce donnée en le considérant comme caractéristique, mais en prenant le risque que cet individu ne soit pas réellement représentatif de l’espèce ? Faut-il représenter un individu idéal de l’espèce qui n’existe sans doute pas en tant que tel dans la nature ? Faut-il représenter un archétype qui constitue une recomposition à partir des éléments jugés comme étant les plus représentatifs, empruntés à plusieurs individus particuliers ? Cette tension entre l’universel et le particulier a traversé toute l’histoire de la représentation iconique depuis la Renaissance dans le domaine scientifique. Ce que les savants et illustrateurs qui souscrivent aux normes épistémiques, pratiques et morales correspondant à l’idéal de véracité de la nature ne cherchent jamais à réaliser, c’est l’image d’un individu particulier, dans tout ce qu’elle présente de variable et d’accidentel, sans exigence de représentation de l’universel. Cet universel est certes bien susceptible d’être appréhendé sous la forme d’une unique illustration, mais celle-ci ne peut être obtenue qu’au terme d’une série d’opérations de sélection, de synthèse et d’idéalisation22, opérations qui présupposent une activité d’interprétation de la part de l’illustrateur ou de son commanditaire.

A partir de là, on peut aisément comprendre que les choix effectués par ces derniers en vue de réaliser l’image source iconique sous forme de dessin ou de gravure sont toujours marqués du sceau d’une certaine subjectivité. Lorsqu’une illustration est considérée comme étant problématique et donne lieu à polémique, c’est essentiellement vers l’illustrateur et les choix qu’il a effectués que l’on va se tourner. Selon Daston et Galison, ces facteurs subjectifs sont considérés comme hautement problématiques vers 1830. En recourant à diverses techniques d’enregistrement mécaniques, dont la photographie, on pense alors pouvoir éliminer l’inévitable filtre subjectif qui s’interpose entre l’objet et l’icône, dans la mesure où la machine enregistre, sans établir de choix. Cette dernière semble permettre d’éviter les écueils auxquels le dessin ou la gravure n’échappaient pas et qui résultaient du travail d’intervention et d’interprétation auxquels se livrait nécessairement l’illustrateur. Comme l’écrit Peter Galison :

- Note de bas de page 23 :

-

Galison, 1999, p. 18 (traduction personnelle).

Les technologies qui visaient à automatiser le transfert de la nature sur la feuille de papier étaient nombreuses, incluant diverses formes de trace mécanique, l’impression directe de l’objet sur la page, avec les camera lucida et obscura. Quand le film photographique entra en scène, à l’instar d’autres technologies qui l’avaient précédé ou qui le suivirent, il fut célébré comme un moyen de se libérer des ‘ressources artistiques’ qui avaient toujours menacé de faire de l’interprétation un élément personnel, subjectif de la dépiction.23

Afin de préciser ce point, je vais développer mon deuxième exemple constitué par une photographie de la nébuleuse d’Andromède.

Fig. 4. Partie centrale de la Grande Nébuleuse d’Andromède photographiée avec le télescope de l’Observatoire de Yerkes, G. W. Ritchey. (Reproduite avec la permission de AAS).

- Note de bas de page 24 :

-

Currie, 2008, p. 150.

Dans les termes de ma typologie, nous avons affaire ici à une image source indiciaire. Elle est le résultat d’un processus causal et suppose l’existence à titre de cause d’un phénomène matériel. Ce dernier « laisse une trace directe sur la photographie elle-même, qui est à cet égard comme une empreinte enregistrée ou une ombre »24, pour employer des termes métaphoriques. L’image source indiciaire résulte en l’occurrence des interactions entre trois éléments :

-

Les rayonnements électromagnétiques émis par l’objet, la nébuleuse d’Andromède

-

Le télescope

-

L’appareil photographique et les procédés de développement

L’idéal d’atteindre une « objectivité mécanique » selon l’expression de Daston et Galison s’est heurté dans les faits à un certain nombre de difficultés liées à la production de ce type d’images : celles-ci étaient dues soit au télescope, soit à l’atmosphère terrestre, soit au recours à la technique photographique elle-même (temps de pose, modalités du développement, etc.). Sans rien dire des deux premières sources de problème qui n’ont évidemment pas été éliminées par le simple fait d’aspirer à une « objectivité mécanique », je me pencherai brièvement sur la troisième source, la technique photographique, conçue comme permettant idéalement de faire l’économie du travail de sélection et donc d’interprétation qui constituait le lot des illustrateurs des siècles précédents.

A partir du cas de la production d’images photographiques en astronomie, on peut montrer que l’espérance d’une évacuation du facteur humain dans l’enregistrement des données s’est avérée vaine. Lors d’un entretien que j’ai réalisé avec Audouin Dollfus, astronome à l’Observatoire de Meudon, ce dernier précisait à propos de la photographie en astronomie qu’il a longtemps pratiquée : « C’est plus un art qu’une science. Les qualités que l’on attend, dans une telle pratique, sont le doigté, la finesse, l’association des doigts et de l’esprit ». L’astronome qui prend des photographies intervient directement au moment de la prise de vue. Il doit notamment choisir le moment où il prend les photographies en tenant compte des turbulences atmosphériques. Je cite à nouveau Audouin Dollfus :

Vous avez des astronomes qui sont totalement maladroits, irrécupérables, et d’autres qui ont un doigté absolument fou et qui savent, même quand tout va mal, récupérer le vent qui fait bouger la lunette, qui savent avec un art consommé, corriger tout cela pour obtenir des clichés magnifiques.

L’astronome intervient une nouvelle fois durant la phase de développement des photographies. Je cite une dernière fois Audouin Dollfus :

J’ai développé moi-même tous les clichés, notamment les clichés les plus délicats. Avec la photographie, on pouvait faire beaucoup de choses : les développer, les tirer, les masquer, les travailler… Il fallait y mettre un peu d’art, un peu de pureté, un peu de savoir-faire… Pour obtenir des images de très bonne qualité.

L’astronome a ainsi toute une série de choix à effectuer quant à l’utilisation de ses instruments de travail. Ceux-ci comportent des limitations et imposent des contraintes tout comme les instruments de l’illustrateur représentant avec ses crayons et ses pinceaux une grenouille ou une orchidée. Comme l’écrit Ernst Gombrich, cela vaut pour l’ensemble des modes d’enregistrement mécaniques :

- Note de bas de page 25 :

-

Gombrich (1982) « L’image visuelle : sa place dans la communication », The Image and the Eye. Reproduit dans Gombrich (2003), Gombrich : l’essentiel, Paris, Phaidon, p. 50.

Par exemple, le mouvement d’un obturateur sur une plaque photographique peut s’avérer trop lent pour montrer la série d’événements qu’il est destiné à capter ; le grain d’un papier photo peut être trop gros pour obtenir le détail voulu dans un cliché. Gottfried Spiegler a montré que l’exigence de lisibilité d’une image aux rayons X peut entrer en conflit avec l’information qu’elle est censée donner. Des contrastes trop prononcés et des contours trop nets peuvent obscurcir des informations importantes. Sans compter qu’on peut très bien retoucher une photographie pour obtenir ou falsifier la vérité. Toutes ces variables interviennent aussi lorsqu’on passe du négatif à l’impression sur papier photo, de l’impression à la photogravure et de la photogravure à l’impression définitive.25

Il faut parvenir à saisir la bonne image, celle qui délivre les informations que l’on juge importantes, par un travail d’ajustement et donc par un ensemble de procédures d’intervention que « l’objectivité mécanique » invitait à bannir. Les normes morales que constituent l’humilité, le renoncement à soi et à sa propre vanité ne peuvent qu’être transgressées au moins à certains moments, par exemple ceux pendant lesquels il faut choisir les temps de pose ou de développement des clichés photographiques ou des images en rayons X. La réduction du facteur humain est donc loin d’être parvenue à son terme avec les images indiciaires de type photographique. Qu’il y ait une connexion causale, que l’image soit indiciaire, ne suffit pas à évacuer le facteur humain comme on vient de le voir, alors que c’était là un des grands espoirs des astronomes.

Pour en revenir à la photographie représentant la nébuleuse d’Andromède, le fait que cette image soit indiciaire permet de souligner que le lien qui s’établit entre l’objet et la représentation est causal : si l’objet subit des modifications quant à sa structure, ses propriétés ou sa localisation spatiale, l’image indiciaire sera modifiée du même coup. Ceci présente un certain nombre d’avantages : l’image semble constituer une « émanation » de l’objet, le lien qui s’établit entre image et objet est donc très fort. Mais d’un autre côté, le prix à payer est élevé. Je relèverai deux inconvénients majeurs qui constituent des sources de difficultés pour les scientifiques :

Premier inconvénient : lorsqu’un fait surprenant ou un problème advient, le scientifique est confronté à une multiplicité de sources problématiques potentielles. Dans le cas d’une photographie comme celle de la nébuleuse d’Andromède, lorsqu’un problème survient, l’astronome doit chercher du côté du télescope lui-même, du côté des conditions atmosphériques, du côté des procédés d’enregistrement et de développement photographiques et du côté des choix et des actions qu’il a effectués dans l’ensemble de la production de l’image. On a ainsi multiplié les niveaux selon lesquels il faut analyser les problèmes.

Second inconvénient : l’image indiciaire est liée temporellement à l’objet : elle représente un objet à un instant t. Une fois que la prise d’image et son développement ont été réalisés, le scientifique ne peut plus guère revenir en arrière. Le résultat est en quelque sorte « figé ».

Ce dernier désavantage sera contourné par l’avènement de l’imagerie numérique. L’idée de l’image numérisée, reposant sur le couplage ordinateur / appareil de radiographie, revient à Godfrey Hounsfield et lui a permis d’obtenir le prix Nobel de médecine en 1979. L’imagerie numérique prend alors son essor : résonance magnétique nucléaire, échographie, caméra CCD, etc. La numérisation des signaux et le traitement des images ont permis à l’image indiciaire via un codage symbolique, de changer de statut sémiotique.

C’est le statut sémiotique des images, en relation avec leurs modes de production et les normes qui conditionnent leurs usages, qui va continuer à retenir mon attention dans cette partie de l’article. C’est pourquoi je vais m’éloigner dans les pages qui suivent de l’analyse de Daston et Galison lorsque ceux-ci parlent d’un troisième type d’images, qu’ils appellent « l’image interprétée » supposant un « jugement exercé ». Comment passe-t-on de « l’objectivité mécanique » qui se caractérise par la passivité du chercheur à un tel « jugement exercé » qui suppose à l’inverse un entraînement nécessaire pour parvenir à une reconnaissance des formes non susceptible d’être réduite à une démarche algorithmique, et la reconnaissance d’une irréductible subjectivité dans l’activité de réalisation et d’interprétation des images ? Ces traits typiques du comportement du chercheur ne me paraissent pas tout à fait propres au développement de la science au début du XXe siècle. On pouvait déjà les trouver chez le graveur ou le photographe, comme en attestent les affirmations précitées d’Audouin Dollfus. Ce qui a lieu, en revanche, dans les années 1920, c’est le fait que les scientifiques ont fini par admettre qu’il était impossible d’éliminer totalement de leur travail la subjectivité, et du coup, ils décident de l’assumer pleinement, voire de la valoriser.

Ce point est certes intéressant, mais ce qui me paraît plus significatif quant au statut sémiotique des images, c’est leur production à l’ère du numérique. C’est pourquoi je vais passer à mon troisième exemple, constitué par une image de galaxie prise avec un télescope spatial à rayons X.

Fig. 5. Image source en rayons X de la galaxie 3C295. D.Harris / Center for Astrophysics

Cette image résulte des interactions entre trois éléments :

-

Les rayonnements électromagnétiques émis par l’objet,

-

Le télescope

-

Le processus « imageant » composé d’une caméra CCD couplée à un ordinateur.

Selon ma typologie initiale, cette image de galaxie est une image source de nature mixte : indiciaire et symbolique. Elle est indiciaire, parce qu’elle possède un ensemble de qualités que possède aussi son objet en vertu d’une connexion causale avec le télescope et le dispositif imageant. Elle est partiellement symbolique car pour obtenir l’image matérielle avec ce télescope, on a recouru à un dispositif imageant intégrant un codage informatique des données qu’il permet d’appréhender sous une forme visuelle. L’importance du caractère mixte des images tient notamment au fait que cette mixité permet de conjuguer les apports issus des théories de la physique et des mathématiques sous forme de calculs et les données issues du monde matériel. En effet, sans le recours à de tels modèles logico-formels, cette image resterait prisonnière de sa temporalité, et serait difficilement exploitable par les scientifiques. Grâce au recours au codage informatique, l’astrophysicien peut aisément corriger les artefacts connus induits par le télescope ou la caméra CCD. Il lui est également loisible d’extraire un certain nombre d’informations de l’image. Il dispose, par exemple, des moyens de réaliser une coupe transversale du rayonnement X émis par la galaxie 3C295. Bref, toutes les opérations que l’on regroupe désormais dans la rubrique « traitement des images » sont des opérations qu’il était pratiquement impossible d’accomplir à l’ère de la photographie et qui ont profondément bouleversé bon nombre de domaines scientifiques.

La mixité des images est donc bien une condition du travail scientifique contemporain, notamment en physique des matériaux et en astrophysique ; il ne s’agit pas d’un phénomène contingent par incapacité à produire des « images sémiotiquement pures », mais d’un projet délibéré permettant de conserver les avantages liés à l’aspect indiciaire de l’image, à savoir la connexion causale avec les objets d’étude tout en atténuant certains inconvénients. Cela permet de détacher en quelque sorte l’image indiciaire de sa fixation temporelle et ouvre la voie à des manipulations de l’image. Cela dit, le fait même que ces images soient mixtes modifie encore les types de difficultés rencontrées par les scientifiques lors de leur production.

En effet, lorsqu’un problème apparaît, le scientifique ne sait pas a priori s’il est causé par la dimension symbolique de l’image (c’est-à-dire par les programmes informatiques) ou par la dimension indiciaire de l’image (le fonctionnement du télescope, de la caméra CCD, des perturbations atmosphériques) ou encore par les choix que le scientifique a effectués lors de la production de cette image. Là encore, le facteur humain n’a pas été évacué, loin s’en faut ! Parvenir à résoudre un problème peut prendre de ce fait plusieurs mois comme j’ai pu le constater lors de mes séjours dans des laboratoires de physique des matériaux et d’astrophysique.

4. Les images scientifiques abordées à partir d’une perspective téléologique

J’ai considéré dans ce qui précède le problème de l’objectivité des images scientifiques en abordant ces dernières à partir d’un point de vue exclusivement génétique, autrement dit en posant la question : comment les images sont-elles produites ? Il me semble qu’en se limitant ainsi à ce point de vue – celui qui consiste à se pencher sur les modalités de production des images – on aboutit à une vision passablement mutilée des traits caractéristiques des images scientifiques à leur sortie du laboratoire et des exigences des scientifiques eux-mêmes en matière d’objectivité. Pour éviter cette réduction abusive, il faut adopter également un point de vue téléologique (dans quel but l’image a-t-elle été produite ? Quelle est la meilleure forme de représentation pour atteindre un tel but ?).

On peut appréhender ce point de vue téléologique à partir d’une formule employée par Ronald Giere dans son ouvrage Scientific Perspectivism. Pour tous les éléments constitutifs des sciences empiriques (équations, modèles, données, et bien sûr les images) : « S utilise X pour représenter W avec les finalités F » (Giere, 2006, p. 60)

Les images scientifiques ne sont pas jugées exclusivement à l’aune de leur capacité à reproduire un aspect de la nature, mais également à partir d’une prise en considération de leurs finalités. Une image scientifique donnée est en effet profilée en vertu de telle ou telle finalité, et les finalités sont multiples dans le cadre du travail scientifique. Comme l’écrit Dominic Lopes (2005), les images scientifiques :

(…) sont utilisées pour formuler des hypothèses, effectuer des démonstrations, décrire des installations expérimentales, confirmer des hypothèses, présenter et analyser des données, tester et calibrer des instruments, et communiquer des données, des résultats ou des hypothèses. On pourrait s’attendre à ce que dans tout contexte scientifique donné, certains types d’images servent mieux certains buts que d’autres types d’images.

A la formule de Giere, « S utilise X pour représenter W avec les finalités F », j’ajouterai la précision : « + les contraintes représentationnelles C ».

Ces contraintes représentationnelles sont principalement de deux ordres :

- Note de bas de page 26 :

-

Sur le point de vue génétique, pour plus de précisions, voir Allamel-Raffin 2009.

-

les contraintes liées à la détectabilité (il s’agit des contraintes d’accès à l’objet que j’ai déjà envisagées, dans les pages de l’article qui précèdent, en abordant les images d’un point de vue génétique) ;

-

les contraintes liées à la lisibilité. Ce sont ces dernières qui correspondent au point de vue téléologique : comment aboutir à la meilleure visualisation possible pour des modalités sensorielles et pour un entendement humains26.

Tout autant que les contraintes liées à la détectabilité, les contraintes liées à la lisibilité gouvernent en partie les choix en matière de réalisation d’images. Que l’on songe simplement au fait qu’après avoir réalisé des images sources, les chercheurs s’en servent non pas comme si chacune d’entre elles constituait une fin en soi, mais comme d’un matériau de base à partir duquel ils pourront réaliser des images retraitées. Ces dernières sont pour leur part caractérisées par leur pauvreté informationnelle au regard des images sources. Mais cette pauvreté est la condition d’une meilleure visualisation des informations qu’elles contiennent. Par conséquent, il n’existe pas pour les scientifiques d’image idéale ou d’image parfaite (cette remarque ne visant pas par ailleurs à nier le caractère plus esthétique ou plus conforme aux attentes des chercheurs de certaines d’entre elles, lorsque ceux-ci parlent de « belle image »). Chaque image constitue un instrument en vue d’atteindre une certaine fin. C’est en prenant en considération ces contraintes liées à la lisibilité que l’on parvient à expliquer pourquoi certaines disciplines scientifiques n’ont pas adopté la photographie ou l’image numérique. Je me contenterai sur ce point d’une brève remarque et de deux exemples.

Ainsi, on notera tout d’abord que le recours à la photographie lui-même peut se comprendre en termes de finalités qui n’ont rien à voir avec « l’objectivité mécanique ». Le recours au medium photographique dans le cas des chronophotographies de Jules-Etienne Marey ou des images en astronomie s’explique avant tout par le fait que leur finalité consiste en la saisie d’un mouvement ou d’une détection qui se situe au-delà des capacités perceptives humaines. Comme l’écrit Joel Snyder :

- Note de bas de page 27 :

-

Snyder, 1998, p. 379 (traduction personnelle).

La plus grande partie du travail de Marey n’entre pas dans le moule que Daston et Galison fabriquent pour lui, quelle que soit la pertinence de leur propos lorsqu’il s’agit d’autres savants qui, au XIXe siècle, ont inventé des machines afin de collecter des données scientifiques. Pour l’essentiel, Marey ne concevait pas ses instruments de précision comme des médiateurs impartiaux destinés à se substituer en raison de leur supériorité à l’œil d’un observateur ou à la main d’un illustrateur. Ses graphes produits mécaniquement et ses images générées photographiquement étaient des manières de visualiser les déplacements physiques décomposés selon des unités de temps déterminées. La décomposition des mouvements physiques se situait hors du champ de la détection humaine et par conséquent, leurs inscriptions ne peuvent pas être caractérisées comme des moyens de visualiser de manière spécialement précise ce qui aurait été réalisé moins bien par un illustrateur ou un scientifique.27

Dans une tonalité voisine, Josh Ellenbogen affirme que, dans certains cas, par exemple

- Note de bas de page 28 :

-

Ellenbogen, 2008, p. 174 (traduction personnelle). Voir également, Allamel-Raffin, 2004, pp. 144-155.

certains types d’imagerie astronomique ou bactériologique, la photographie permet de visualiser des entités et des événements imperceptibles, qui peuvent seulement être connus photographiquement, et pour lesquelles il n’existe pas de données disponibles en dehors de l’enregistrement photographique.28

Je vais préciser d’autres finalités dans le cadre des deux exemples qui suivent. Le premier est emprunté à Dominic Lopes (2005). Il s’agit des dessins lithiques – autrement dit des dessins archéologiques d’artefacts réalisés par des hominidés, en particulier des outils en pierre taillée. Pourquoi les archéologues ne réalisent-ils pas des images photographiques ou des images numériques afin de représenter ces types d’artefacts ? Ce n’est pas en raison de contraintes d’accès liées à des difficultés à détecter l’objet. C’est en raison de contraintes de lisibilité que les archéologues continuent à dessiner les objets lithiques. Notons que les champs disciplinaires qui se sont intéressé à la photographie, et typiquement l’astronomie, sont ceux qui rencontraient dans leur entreprise les plus grandes difficultés de captation des phénomènes étudiés. Or dans le cas du dessin lithique, l’objet soumis à investigation ne pose pas de problème de captation : il est de taille macroscopique. La finalité visée par les archéologues n’est pas d’attester que l’objet existe effectivement, de produire un certificat d’existence ou de déterminer ses propriétés, mais d’indiquer de manière précise comment cet objet a été fabriqué. L’image photographique, de ce point de vue, est moins pertinente quand il s’agit de donner à voir le processus de fabrication de l’objet qu’un dessin réalisé par la main humaine. Ce dessin permet : 1) de rendre compte des angles selon lesquels le matériau, la pierre, a été frappée pour aboutir à sa forme finale ; 2) de surimposer un codage adopté universellement par les archéologues permettant de souligner les opérations imposées au matériau (frotter, casser, etc.). Le dessin lithique est donc à la fois iconique et symbolique.

Mon second exemple est constitué par l’œuvre d’un botaniste, Gaston Bonnier, Flore complète en couleurs de France, Suisse et Belgique, parue au début du XXe siècle. Bonnier a cherché à établir un compromis en recourant simultanément aux deux techniques – dessin et photographie – sur un même support. Son objectif était ainsi de combiner les avantages respectifs de l’indiciaire et de l’iconique. Le contour des photographies est redessiné à la main afin de mettre en évidence les détails importants. La qualité des images ainsi obtenue est telle que l’ouvrage de Bonnier a été constamment réédité.

Dans ces deux exemples brièvement exposés, les chercheurs ne recourent pas ou pas exclusivement à la technique de la photographie, car la finalité des images n’est pas d’attester l’existence des objets. La finalité est plutôt de mettre l’accent sur les détails pertinents – et dans les deux cas, la photographie a été considérée comme trop peu sélective. Ainsi, en fonction des disciplines, des objets d’étude et des finalités qu’ils s’assignent, les scientifiques mobilisent tel type de technique permettant de produire des images ayant tel statut sémiotique déterminé. Dans un domaine de recherche où la première difficulté réside dans la captation des données, typiquement l’astrophysique ou la physique des matériaux, les chercheurs vont se tourner vers des dispositifs imageants permettant de produire des images partiellement indiciaires. Une des finalités est d’attester l’existence même de l’objet avant de procéder à l’étude de ses propriétés. Dans des domaines telles que l’archéologie ou la botanique, où l’existence de l’objet ne fait pas problème, les finalités étant, par exemple, soit de montrer des processus (la manière dont la pierre a été taillée), soit de cerner les caractéristiques essentielles des plantes afin notamment de les classer en respectant certains principes taxinomiques, on privilégiera le dessin. Dans ces cas, le dessin, moyennant l’établissement de conventions strictes, est plus objectif au regard de la finalité que les scientifiques visent. L’objectivité telle que la conçoivent les scientifiques n’est donc pas à mettre en relation avec le primat d’un statut sémiotique de l’image par rapport aux autres et on songe ici en particulier au statut indiciaire. Tout dépend en définitive du contexte, de l’objet et des finalités que l’on assigne à l’image.

5. Vers une définition composite de l’objectivité scientifique

- Note de bas de page 29 :

-

Douglas, 2004.

- Note de bas de page 30 :

-

Qu’une image isolée n’est généralement pas considérée comme suffisante pour entraîner l’adhésion des pairs dans les sciences expérimentales a été souligné par maints auteurs appartenant à des courants de pensée variés. J’évoquerai seulement – en dehors des sources relevant de la philosophie des sciences anglophone figurant dans le corps de l’article – les remarques formulées sur ce point par Bruno Latour (1993).

- Note de bas de page 31 :

-

Allamel-Raffin, 2003, 2005a.

Mais, et ce sera le dernier point abordé dans cet article, le degré d’objectivité d’un résultat obtenu au terme d’un processus expérimental, par exemple une image, se mesure-t-il à partir de l’unique dimension constituée par les techniques de production de ces images, dimension que l’on peut identifier grossièrement à « l’objectivité mécanique » ? Lorsqu’on parle de l’objectivité des procédures adoptées dans les sciences expérimentales, peut-on se contenter d’un seul trait définitoire ? Il semble bien que non. La démarche de Daston et Galison vise à constituer une périodisation des comportements des hommes de science en identifiant des normes épistémiques, pratiques et morales étroitement entremêlées au fil des siècles. Mais les normes adoptées au sein d’une discipline constituée en tant que science normale (au sens que T. S. Kuhn confère à cette expression) ne se limitent pas à déterminer quel type d’image est pertinent et à quelles procédures il faut recourir pour les produire. Ce qui importe également, pour la constitution de l’objectivité des résultats obtenus au sein d’un laboratoire, c’est la relation que l’on doit pouvoir établir entre les images. Ainsi, afin de réduire la dimension subjective dans l’entreprise de production des images, les scientifiques mettent en place des procédures qui permettent d’aboutir à une objectivité convergente29. Celle-ci a été l’objet de maintes attentions depuis l’article de William C. Wimsatt paru en 1981, « Robustness, Reliability, and Overdetermination ». Pour nous en tenir aux images scientifiques : ce qui frappe l’ethnographe qui se rend dans un laboratoire de physique des matériaux et observe les pratiques d’exploitation des images produites, c’est le fait que les chercheurs accordent en règle générale une faible valeur épistémique à l’image isolée30. Dans plusieurs articles déjà publiés31, j’ai proposé d’employer le néologisme « d’interinstrumentalité » pour décrire le type de procédure objectivante consistant à recourir à des instruments scientifiques dont le fonctionnement repose sur des principes physiques différents et à croiser les résultats obtenus en vue d’établir leur convergence. Par exemple, dans une étude déterminée relative à la présence d’un effet magnétique dans un échantillon de rhodium sur or, les physiciens ont recouru à trois méthodes d’investigation distinctes :

-

la spectroscopie Auger qui fournit des informations d’ordre chimique ;

-

le microscope à effet tunnel, qui délivre des informations concernant la surface de l’échantillon ;

-

le Moke qui permet d’obtenir des informations magnétiques.

- Note de bas de page 32 :

-

Franklin, 1986, 1990 et 1998.

Le recours à ces trois types d’instruments fonctionnant sur des principes physiques différents et apportant des informations de natures différentes se concrétise sous formes d’images. C’est la convergence des résultats obtenus au moyen de ces images qui a permis d’expliquer l’absence de magnétisme du rhodium sur or, alors que la théorie avait pourtant prédit le contraire. C’est la convergence des résultats qui accroît le degré d’objectivité de cette conclusion. Une telle stratégie, l’interinstrumentalité, s’inscrit en réalité dans un ensemble plus vaste de procédures visant à accroître le degré d’objectivité convergente de la recherche : songeons par exemple à la stratégie qui consiste en la comparaison d’une image source avec une image de simulation. L’ensemble des stratégies expérimentales qui inclut notamment un ensemble de procédures relatives à la traque des erreurs a été bien répertoriée par le philosophe des sciences Allan Franklin, dans plusieurs de ses ouvrages32. Ces stratégies consistent en :

-

l’élimination des sources d’erreurs plausibles et l’élimination des possibles explications alternatives permettant d’expliquer un phénomène.

-

les vérifications expérimentales et les phases de calibration durant lesquelles un instrument reproduit un phénomène déjà connu ;

-

la reproduction d’artefacts (d’effets indésirables) déjà connus ;

-

l’intervention, durant laquelle l’expérimentateur manipule l’objet étudié ;

-

l’interinstrumentalité ;

-

le recours aux résultats expérimentaux eux-mêmes pour étayer la véracité d’un phénomène ;

-

le recours à une théorie indépendante et bien corroborée par ailleurs ;

-

le recours à des arguments statistiques ;

-

l’analyse des résultats en aveugle.

C’est le fait de croiser plusieurs de ces stratégies qui permet de constituer l’objectivité convergente. Mais quel que soit le nombre de tests effectués dans le cadre de chaque stratégie, et quel que soit le nombre de stratégies exploitées, on ne peut jamais qu’accroître le degré d’objectivité convergente des résultats obtenus. La conception de l’objectivité qui découle d’un tel constat est que celle-ci doit nécessairement être pensée à partir d’une perspective gradualiste. Une telle perspective a été adoptée par un grand nombre de philosophes des sciences, parmi lesquels on compte Sylvia Culp, Helen Longino ou Hilary Putnam. Ce dernier affirme notamment : « l’objectivité visée par les scientifiques n’est pas affaire de tout ou rien, mais de plus et de moins » (2003, p. 146). Par conséquent, l’objectivité est affaire de degrés (Culp, 1995). Elle est donc nécessairement modérée et doit être conçue sur le mode d’un continuum, comme l’énonce Hilary Putnam :

Considérons nos énoncés comme reposant sur un continuum (de manière à ce qu’il n’y ait aucun point où commence l’objectivité) ; et disons que les énoncés qui dépendent éminemment de nos intérêts et de nos points de vue, et tout particulièrement ceux qui procèdent d’un point de vue idiosyncrasique, ou qui sont émis par des personnes indifférentes aux intérêts des autres ou à d’autres points de vue appropriés, se situent à l’extrémité « subjective » du continuum, tandis que les énoncés deviennent plus « objectifs » au fur et à mesure que leur prétention à la vérité dépend moins de ces points de vue idiosyncrasiques et de l’indifférence à l’égard des points de vue et des intérêts des autres (2003, p. 141).

Conclusion

La première leçon que l’on peut dégager de l’ensemble de l’étude qui précède est qu’il est impossible d’adopter un point de vue de nulle part, même si cela a constitué l’ambition des scientifiques du passé lorsqu’un type de technique de production d’images semblait avantageusement devoir en remplacer un autre. Ce que l’analyse en termes sémiotiques des images produites au moyen des différents types de technique autorise à souligner, c’est qu’on a bien plutôt assisté à chaque fois à un déplacement des problèmes d’ordre pratique que rencontraient les chercheurs. Quelle que soit la technique de production d’images, et quel que soit le gain en termes de captation et de contrôle des données collectées sous forme d’images, il sera toujours nécessaire d’opérer des choix qui supposent le point de vue d’un être humain, de ses savoir-faire et de son jugement – et donc l’inévitable intrusion d’une dimension humaine subjective.

La deuxième leçon concerne la perspective de Daston et de Galison qui ont mis l’accent dans leurs travaux sur les normes épistémiques, pratiques et morales qui ont visé à réduire la part de subjectivité toujours présente dans la phase de production des images. Il me semble qu’une part de subjectivité est également repérable dans la dimension du travail scientifique qui consiste à profiler l’image que l’on cherche à produire en vue de finalités précises. La repérer et la caractériser suppose de la part de l’analyste qu’il adopte ce que j’ai défini comme étant un point de vue ou une perspective téléologique. Une image scientifique, une fois réalisée, est considérée comme plus ou moins objective – et pour caractériser cette objectivité, il convient de prendre en compte à la fois les contraintes de détectabilité (correspondant au point de vue génétique) et les contraintes de lisibilité (correspondant au point de vue téléologique).